腾讯优图贾佳亚:人工智能多模态的未来

2019-07-26 18:37:37爱云资讯

贾佳亚是香港中文大学终身教授、腾讯优图实验室联合负责人、腾讯杰出科学家、IEEE Fellow,是计算机视觉领域著名专家,由他创立的图像滤波和逆向视觉问题解法已经被许多高校教科书和开源视觉代码库收录,同时也在视觉商业系统中得到广泛应用。在今年上海召开的市北 GMIS 2019 大会上,我们邀请到了贾佳亚教授,分享人工智能多模态的现状、挑战和未来。

人工智能领域学科发展现状

之前很多媒体、投资人、各类公司的创始人大佬问我一些问题:人工智能发展到现在,大家从不知道到知道,再到后来知道它有局限性、有发展性,那人工智能现在处于什么阶段呢?当我们对人工智能比较乐观的时候,这个乐观的心态能够走到哪一年?如果我们觉得比较悲观,发现很多问题人工智能其实做得并不好,那么我们应该怎么看待这些悲观的情绪?当很多学生选择以后职业,甚至选择以后自己想做研究生或者从事教育工作、研究工作的时候,他是不是还要以人工智能为核心?

其实我对这个问题有很长时间的思考。我在不同场合讲了很多我对这个问题的理解。这个月我真正整理了一套我自己的观点。

我到底怎么看人工智能的路向?它最基本、最核心的问题是什么?我们怎么能够看到人工智能接下来是不是还有 10 年、20 年,甚至 50-100 年的发展?这是非常长期的观点。今天我给大家介绍一下我自己的看法。

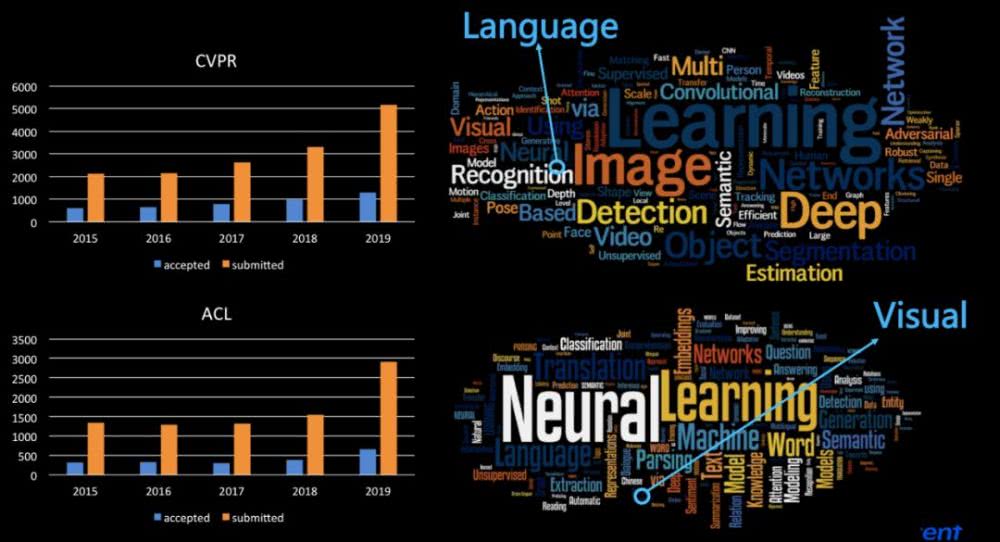

首先是发展现状。这个发展现状很有趣,我们来摆事实讲道理。这个事实就是,我们看到一个很简单的现象:过往五年 CVPR 投稿和接收论文的数目,这几年里每年 CVPR 投稿的数目以 50% 的速度增长,今年投稿数是 5000 多,预计下一年应该是 7000 左右的投稿数目,这意味着有非常非常多的新研究人员加入,中国这一块的力量是非常巨大的。我们再看另外一个自然语言处理顶会 ACL,ACL 这两年论文数量增长速度也非常快,今年比去年增长快一倍的重要原因是自然语言处理突然出现了井喷,比如一个算法的突破(如 BERT)导致大家觉得很多问题可以开始解决了,对自然语言处理的理解问题可以比原来做得好很多倍。

上图右面是今年 CVPR 的关键字,比较显著的字如图像 (image)、检测 (detection)、识别 (recognition)、深度 (deep) 等,但是在一个非常小的你根本看不见字的小框框里面是什么?是 language,是文字、语言。这个不是机器学习发现的,这个是人肉学习发现的。然后我们再看自然语言处理顶会 ACL 的关键字,有 neural、learning、model、text,绝大部分的论文都是有关这方面的内容,但是我们仔细看看里面一些非常不起眼的地方,原来这里面有一个很小的词——visual。

这张图说明了一个非常有趣的问题。各个领域的人工智能在蓬勃地发展,每个领域都觉得自己做得很有意思。但是这些领域基本上是分离的。这个观点可能以往很少人提出。实际上在这些领域里面,虽然大家觉得人工智能是一个整体,其实并不是,现在看起来人工智能是分隔的孤岛。人工智能的每一个模块,比如视觉是一个孤岛,自然语言处理是一个孤岛,声音也是一个孤岛,等等。

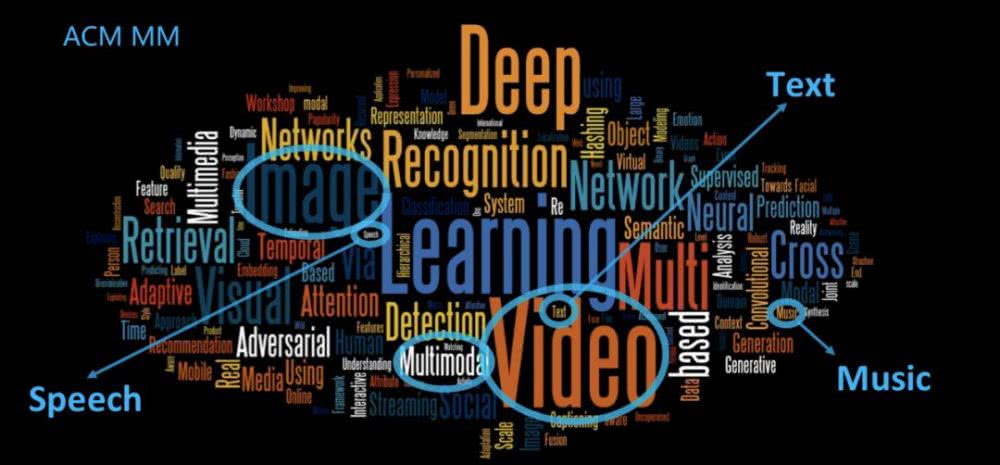

然后我们再看 ACMMM。这是一个交叉学科的会议,领域融合应该做得还不错吧。我们可以看到绝大部分的词是 learning、vedio、image,看起来已经是多媒体的东西,但是你仔细看这里面只有很小一部分是关于音乐 (music)、文字 (text)、声音 (speech)。这说明这里面的发展是不全面的,不是我们想象的那样人工智能蓬勃发展导致整个领域发展是以一个口径或者以一个方向在往前走,其实并没有走到这一步。

我们看看原因是什么呢?很简单,任何一个技术的发展都是以单点突破为基础。

从 1997 年的深蓝慢慢发展到 2014 年的人脸识别,到 ImageNet、AlphaGo、德州扑克、Dota2。其实这些都是单点突破,也就是说人脸识别算法不能用于下围棋,下围棋的算法不能用于打游戏,这些算法都是单点突破,当然这也是很正常的。

我们早期在做计算机研发的时候,每一个计算机的每一个模块都要单独研发的,比如说显卡、CPU 有专门厂家研发,芯片组是另外一些公司在做,还有系统是另外的公司在做。这些也都是单点突破,但是突破之后到现在把它们整合到一起,发现原来个人家用电脑,我们现在所用的服务器或工作站已经很强大了,这是因为单点突破做得很好。毋庸置疑需要走这一步。

人工智能学科发展与人类智能差距还很大

单点突破已经做了这么多事情,但实际上整个人工智能的发展离真正的人类智能整体发展差距相当大,二者的差距之一是多模态信息的智能化理解,到现在为止很少有专家系统化涉猎这个领域。

为什么会出现这个问题?

我们首先看看人类智能是怎么发展的。人类智能的发展需要 sensation。特拉维夫大学心理学院院长塞尔玛·洛贝尔在著作《Sensation: The New Science of Physical Intelligence》中表示:「对世界的感官体验不仅能对我们自认为理性公正的思维产生影响,还会左右我们所谓的自主思考能力」。人类对世界的感知系统是非常严谨而复杂的。

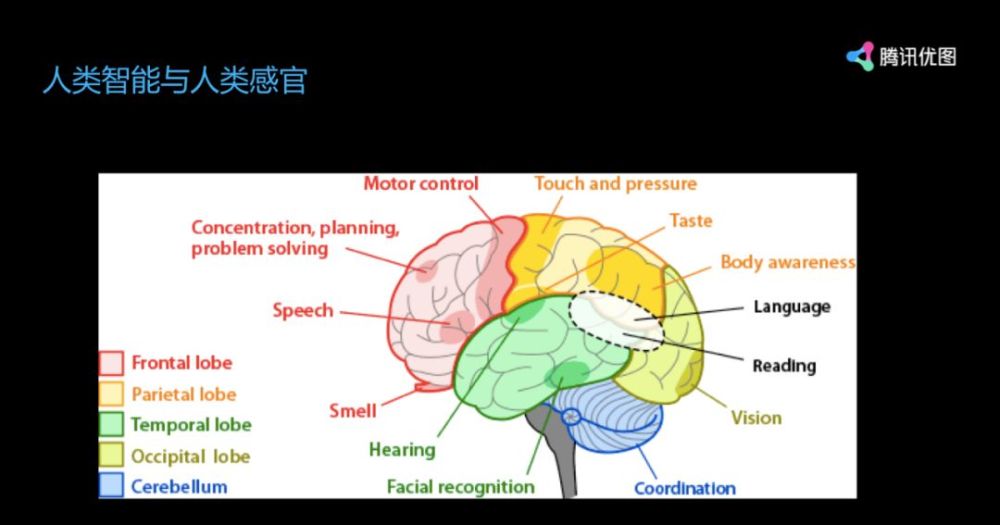

但是,现在机器学习还没有做到这一步,其中有一个重要的点。我们看看人脑分布,人脑是一个整套的系统,你不会觉得把人脑中间某一部分切除还可以愉快地生活。

人类大脑涉及很多部分,有听觉部分、嗅觉部分、说话部分,还有抽象思维能力、动作控制,以及味觉、language。人脑系统是一个整体系统,你去除哪一部分,可能其他部分工作得也不好,但是人脑这套体系在现有人工智能的框架下是不存在的。现在世界上还没有任何一个体系、任何一套人工制造的系统具备如此多功能的模块,同时又整合在一个整体里面,能够交叉互动。

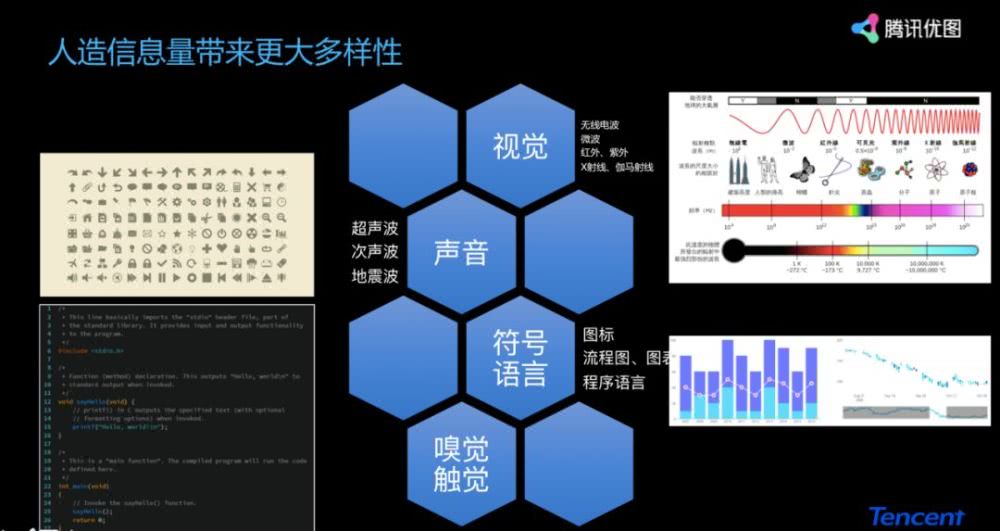

我们看到人脑已经有这么多信息处理的功能,有这么多的感官,那么人造信息实际上有更多的可能性。

比如说人的眼睛看到可见光,但是在人造的信息里面,可见光是非常小的一部分。在科学探索、实验仪器里面,视觉领域除了可见光,还有微波、红外线、紫外线、X 光等等。在声音里面,除了我们人类听到的声音之外,还有超声波、次声波、地震波等通过现代机器探测设备听到的声音。此外我们还有符号语言,比如图表、编程语言。除此之外还有嗅觉、触觉,这两个领域基本上还没有研究,你不会碰到一个人说我研究嗅觉的,现在大家还见不到这样的专家学者。

说到这里大家明白了,我们现在要做这么多事情,实际上我们现在研发的每一个单点的突破,即使是我们认为了不起的下围棋、打游戏方面的突破,其实都是非常小的,只是人可以做到的事情中的很小一部分。实际上人最强大的地方就是能够把各种各样的能力捆绑在一起,做一个统一输出。就像我们卖产品一样,要真正垄断一个行业,必须把所有垂直的产品都包括了,去建生态。其实人的大脑已经把这个生态建好了。

多模态人工智能的基础难点

那么多模态发展的基础难点是什么?机器要想做到人这样的功能,还存在很多问题。

数据模态多种多样

第一个,我们要接受这么多的信息,有图像、模型、结构化信息、文本、声音,那怎么把这些东西融合起来?融合起来的过程一定是很需要的,肯定要融合。大家觉得目前哪一个产业跟多种信号的连接是最相关的?很多人觉得是机器人产业。不是,机器人离我们很远很远。机器人是一个玩具,根本实现不了我们要做的任何事情。我一直说,如果机器人达到能带小孩的地步,那说明确实人工智能已经足够强大。但是我觉得在 20-50 年内,未必能看到这一天。

我觉得,把多种信号融合在一起跟我们最相关,而且接下来 5-10 年就能看到的领域,是汽车。汽车真正需要声音,需要多种符号、文字,汽车是我们每天都在使用的工具,同时它又具备了外部的感应器、内部的感应器,车的处理能力也会越来越强大,加上 5G 的技术,我们还能够通讯,车可以像人一样互相交流。汽车行业可能发生翻天覆地的变化。我的预测未必正确,但这个比机器人更靠谱一些。

我们还有很多无法量化的数据,就相当于没有数字化的数据,是很难很难处理的。你可以想象,计算机全部是 01 处理,现在没有 01 时候的时候怎么处理呢?比如说嗅觉,什么叫香,什么叫臭,什么叫好闻。还有味觉,哪个好吃,哪个不好吃,你喜欢酸的还是甜的,为什么有的味觉会改变有的不会改变。以后想创业的同学,大家应该多想想这方面,这里面还是有很多创业机会可以挖的。

多模态数据不对应

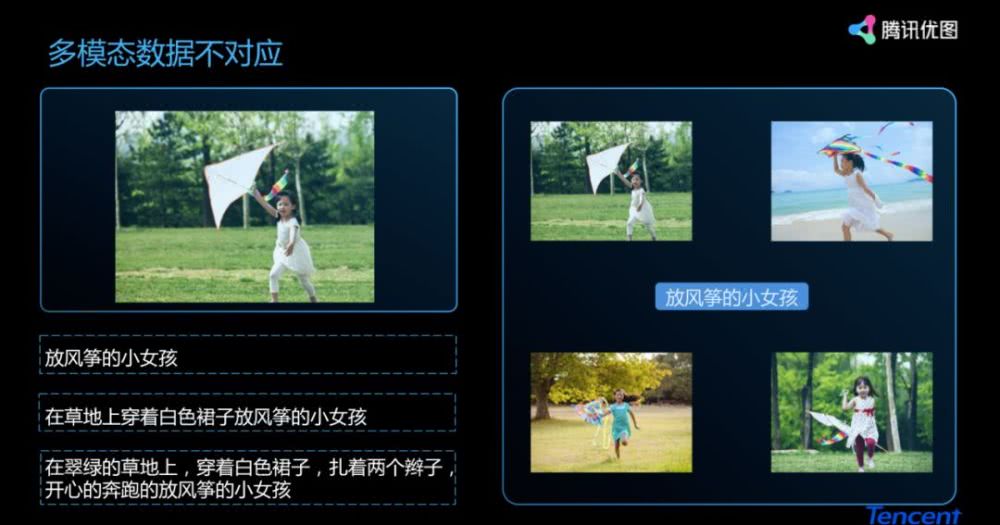

基础难点还包括多种问题,比如多模态数据不对应的问题。我们看到一幅图像后,可以用很多文字形容它:放风筝的小女孩、在草地上穿着白色裙子放风筝的小女孩、在翠绿的草地上,穿着白色裙子,扎着两个辫子,开心的奔跑的放风筝的小女孩。这些都没有错。这很明显是一年级、三年级、五年级小学生写的东西,你能感受到写作层次不一样。

同样道理,我们看到一句话,然后去寻找它所对应的视觉信息,你会发现这些信息也是一对多的。到底怎么去解决这个问题呢?怎么完整地定义多模态数据不对应的问题,并解决它?

多模态数据的融合

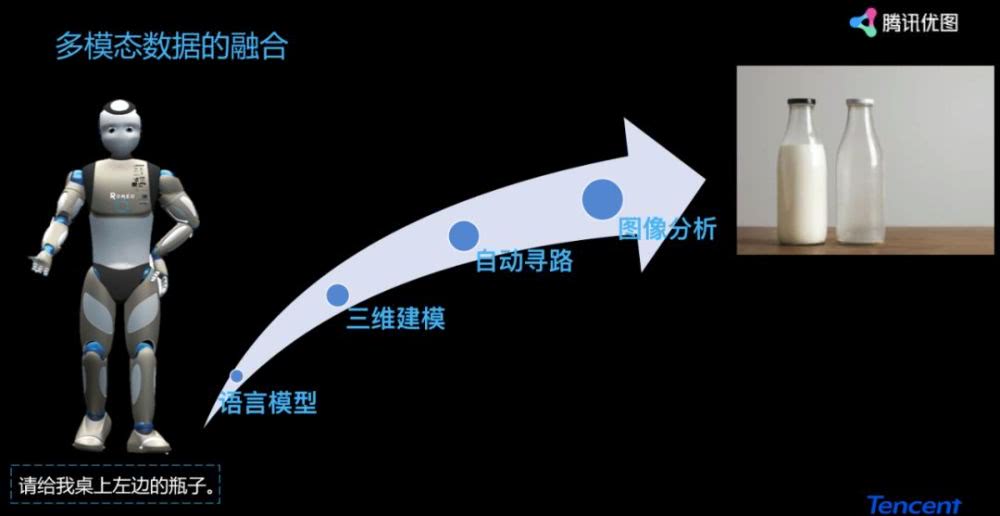

还有一个问题是多模态数据的融合。像刚才说的,假设机器人实现智能化还有非常长的路要走,但是在过程中间我们要公关的问题是什么呢?比如你对机器人说「请给我去卧室拿桌子上左边的瓶子」。很简单的事,每个人都会做,可能两三岁小朋友都会做的事情。他知道什么是瓶子什么是卧室,就过去拿了,可能中间会洒掉,可能会把瓶子摔了,但是这并不妨碍他拿到瓶子。

而如果是机器人的话,中间有很多的步骤要做。首先要构建语言模型,要三维建模,还有自动导航,不然机器人哪知道怎么走到卧室。最后是图像分析,什么叫桌子、什么叫瓶子、瓶子有多大、里面装了什么东西、怎么拿最好。这些都是不可避免、一定要解决的人工智能问题。

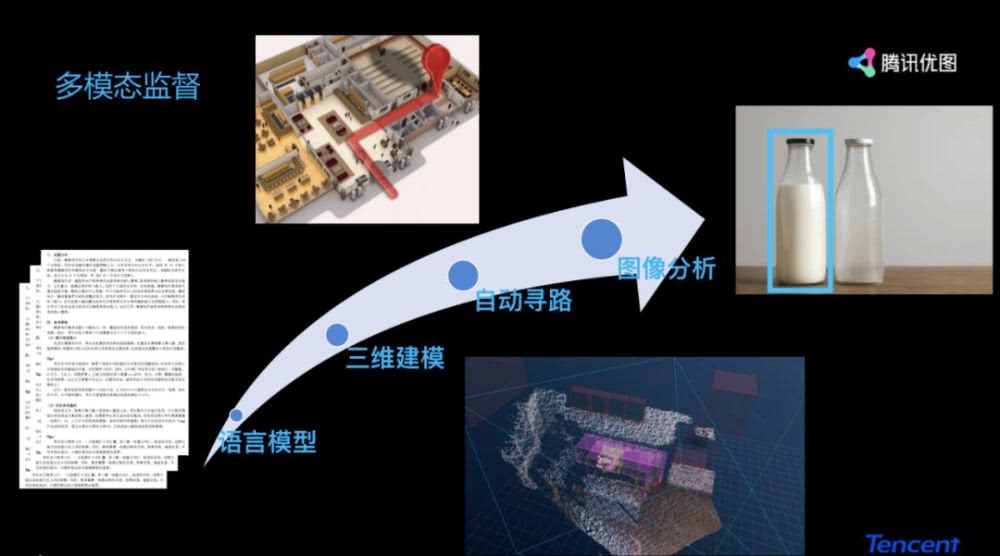

最后机器人还需要监督。机器人做这么简单的事情就有这么长的链条要处理,那每个链条出错了怎么办?假设链条一语言模型做错了,机器人听错了,听成「把我的被子搬出来」,然后找了半天发现桌上没被子,最后把桌子搬出来了,这个是不能接受的。那你回去要监督它,告诉它这件事情做得不对,你以后不能做这件事情,什么时候该停止,该怎么做,这是个监督问题。这里涉及到语言模型怎么监督,涉及到非常复杂的单点突破,也就是说语言模型首先要单点突破。

再往下 3D 建模,今天房间是这个样子,明天比如家里人把桌子给移了位置,3D 建模变形了,桌子找不着了,那机器人还能不能找到桌子?这是另外一个监督问题。第三个自动导航的时候,当里面空间变化时要怎么办?做错了怎么办?最后图像分析里图像理解的问题,分割、检测、3D 点云分布问题。

这其实是个很简单的问题,刚才说到的带小孩的问题难度远远超越这个,应该是一万倍以上。而这个简单的问题实际上也非常难做。所以现在绝大部分的机器人基本上都是做一些非常简单的操作,跳舞、唱歌、眨眼等,大家觉得机器人能做到这一步已经很开心了。但是大家可以设想以后机器人的发展,发展空间是非常之巨大的。

腾讯在多模态人工智能的初步探索

立足于腾讯,我们做了非常多有趣的探索。

我们看一下这个视频(见前文视频),我想问问有多少人知道视频里这个小哥哥想要表达什么内容?没有是不是?这个视频我已经在超过十个地方给不同场合的观众演示过,基本上大家知道这肯定是手语。但问到具体内容是什么意思时,没有一个人答得上来。今天给大家讲的就是,我们在实验室里面做了一件非常有趣的事情,做了一个手语翻译器。

为什么做这个事情?

给大家看看数据。我国的听障人士是 7200 万,占全国总人口的 5%,全世界有 4.6 亿的人有残疾性的听力损失,超过全世界人口的 5%。这两个数字非常巨大,但是我们从来没有意识到。你打开朋友圈,随便挑 20 个人出来,你能找到任何有比较严重听障问题的朋友吗?基本是没有的。

把这个数字再扩大一点,你挑一百个人出来,这一百个人里面有任何一个人有听障问题的吗?基本上也没有。这个事情说明什么呢?其实我们在做这件事情的时候,当我们想深入解决这个问题的时候,突然发现一些问题是多么的严峻,我们普通人接触到的社会跟另外一群人看到的社会是不一样的。因为你在自己身边找不到任何一个有这样问题的朋友,这也意味着你的朋友在他的朋友圈里也找不到这样的朋友。

这个问题推演下去,你会发现普通人和弱势群体这两个群体通常是相互隔绝的,完全没有交集。这是非常可怕的事情。我们后来想去做这件事情的初衷是做了一项调研,调研结果非常令人震惊。我们突然发现原来这样一件事情好像有很大需求,比如我想理解手语,没有一个普通人理解什么叫手语。这就导致有听障问题的朋友实际上没有办法跟路上碰见的任何一个陌生人交流。最后两个圈子就完全隔离开了。

我们在做这件事情的时候,肯定要有数据。大数据是很重要的,在收集数据的过程中,我们想到手语数据不是有很多嘛,中央电视台下面经常有一个小人在比划。我们去问深圳手语学校的老师和同学,他们说我们看不懂中央电视台的手语。这说明什么呢?说明手语是有方言的,到现在为止中国手语没有统一标准。也就是说我们在深圳学到的手语和在上海学到的手语是不一样的,是没法沟通的。比如我从深圳过来讲的演讲,从全国各地赶过来的朋友们都能听懂我的讲座。但是你要聚拢一帮来自五湖四海有听障问题打手语的朋友,他们是没法交流的。你突然发现数据非常难搜集,因为中国现在没有一套统一化的手语规范。

另外为什么做这个事情?像我们每一个人辅助一位孤寡老人,送鸡蛋什么的,这个实际上能做的事情太少。我们希望通过大公司的平台,通过技术的力量发动大家对弱势群体的关心,比起个人力量,这个影响力是几何级的扩张。

这里面有很多的问题。但是你看技术本身,它就是一个大数据弱监督的手语识别解决方案,中间涉及到非常多需要解决的问题。

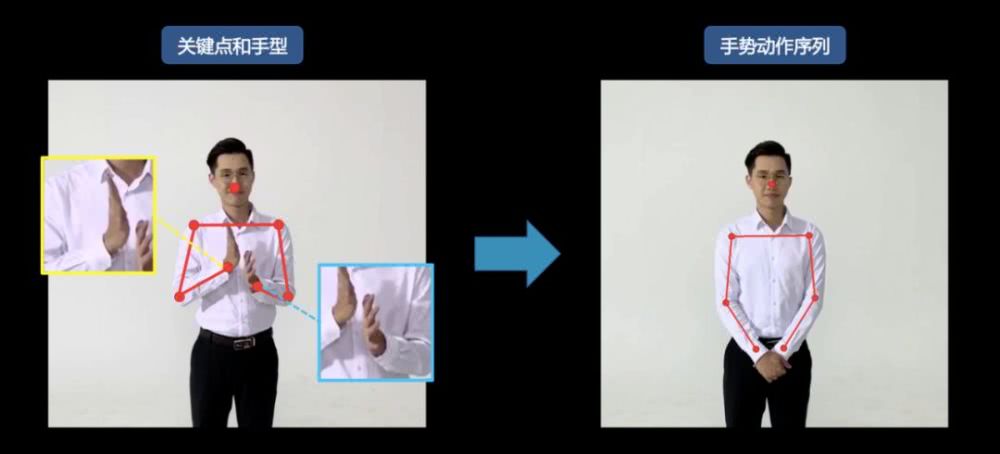

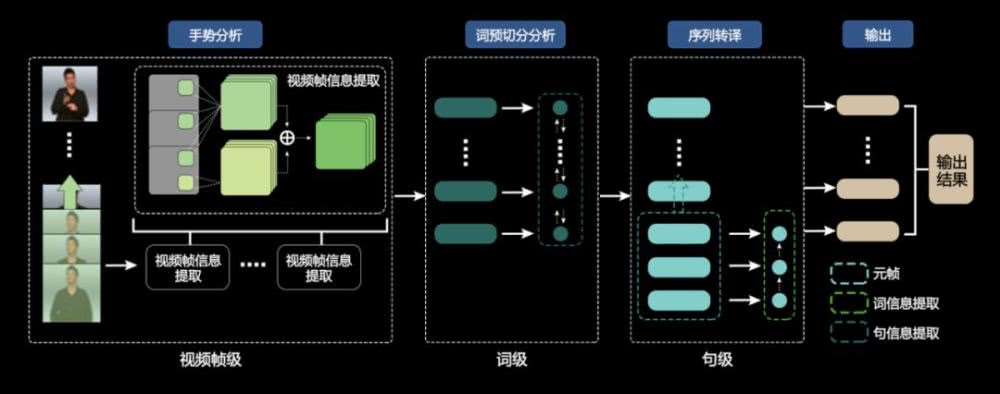

既然讲多模态,你会发现手语翻译器在技术层面上也不简单。除了刚才说的数据问题和国家标准问题之外,我们发现原来手语涉及到很多模态的理解。它需要手指姿态识别(图像模态),然后是动作识别(时序模态),然后语义转化(模态转换),最后语言模型(语言模态)。

比如这个例子:

首先我们需要做一个非常精准的人体骨骼特征抽取,抽取完特征之后再转换成语言模态。

这个序列变成一个字,另外一个序列变成其他字,然后再把它合起来。每个字可能单独看起来都不是特别有意思,但是合成一句话之后就是语言的融合。也就是说从单点的每一个词变成整体的可理解的语言,又是一个这样的技术过程。最后我们把整个序列变成一句话,就得到一个结果了。

下图展示了大致流程,也还是蛮复杂的。

我们最后做了一个界面。刚才我们看不懂的那段话(手语),手语翻译器可以识别、理解,并把每个字打出来,当你看到每一句话的时候,你可以做反馈,反馈也会被变成手语,被传递给对方。这个翻译器真的是有趣的,当你觉得外语是很难的语言时,我想说的是手语对我们社会是非常重要的,也是需要的工具。

我们在这个过程当中解决了很多多模态的事情,做了很多的研究工作,现在还有很多问题。

即使是在简单的语言和图像多模态里,数据也是非常不均衡的。通常大家看到这张图像会问图里有没有长颈鹿,但是没有人问有没有羚羊。你会发现,这两种句子的问答是完全不一样的。

当然里面还缺乏多模态的监督。比如中间这张图里没桌子,你问桌子是什么颜色,它只好找到灯笼,然后回答是红色。

此外还有很多视觉问题没有得到很好地解决。这么多人挤在一块的时候,你如何把每个人分割出来,视觉问题也是很重要的问题。

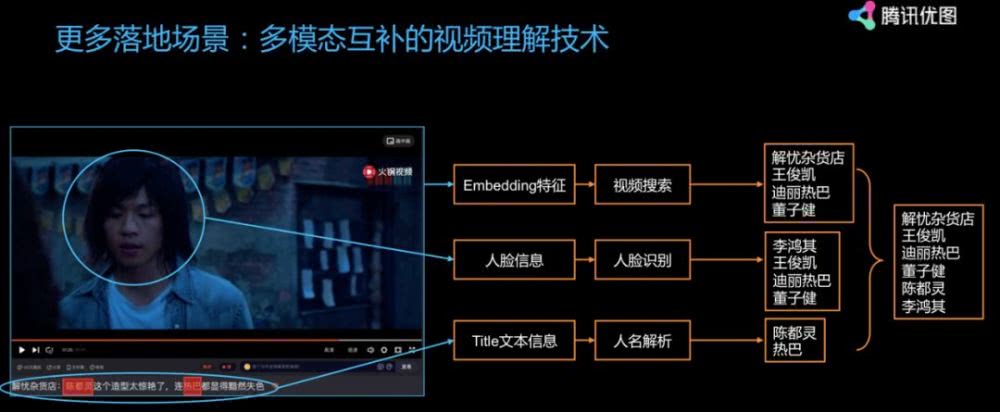

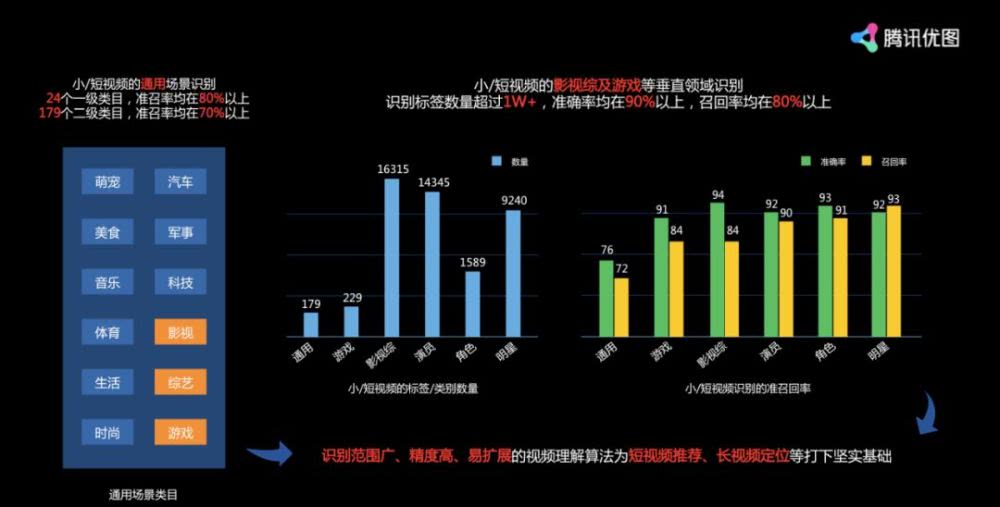

我们还做了很多事情,比如我们在腾讯视频里,在腾讯整个内容平台上做了非常多交叉融合,在落地上也做了非常多。比如我们通过视频内容、图像内容、标题内容得到非常多的精准理解。

最后看多模态在落地方面也是有非常大的应用,除了刚才提到的机器人,它在内容平台上也是非常重要的。

多模态的未来发展

关于多模态未来的发展,我觉得首先要解决难以量化的东西,比如嗅觉、味觉、触觉、心理学。这些 AI 完全没法涉猎,没有办法真正地介入其中。现在谁能够打出第一枪,能把这件事情做好,我觉得也是很有意思的将来,大家可以将它作为科研或者创业的一个方向。

大家看这张图,能想到气味对不对?那怎么通过多模态把不可能存在的计算变成可能呢?

比如你发现原来第一个是「芬芳」,第二个是「香醇」,第三个是「香喷喷」。这些词在你的脑子里立刻被转换成一种感觉。那怎么去表达那种感觉呢?我们是否可以通过多模态计算使得非量化的信号得到计算。比如「芬芳」减去「香甜」小于「芬芳」减去「恶臭」。这个我想大家能够理解。但是要让它在计算机上变成可计算,还需要看看怎么去量化里面那些标准。

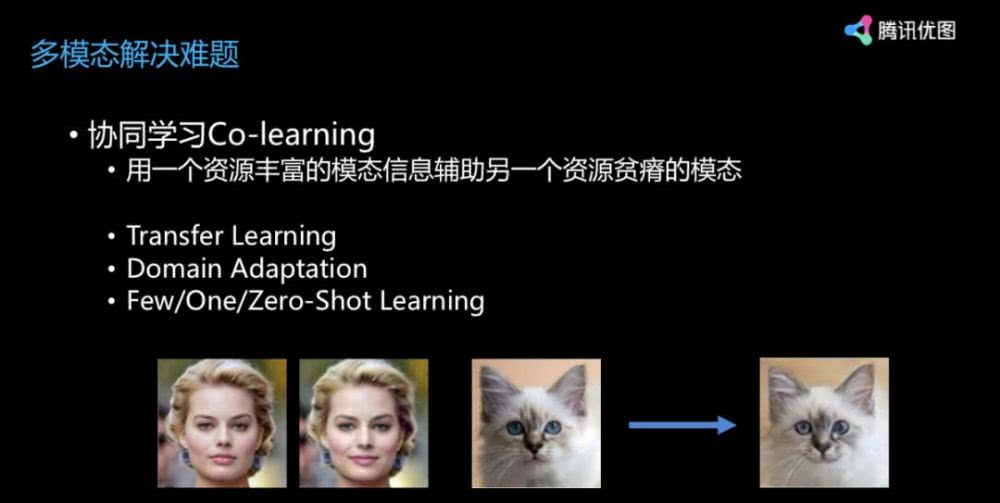

多模态里有非常多的问题,所以我们引入了非常多的其他方法,transfer learning、domain adaptation、few/one/zero-shot learning 等方法都是比较好的研究方向。

我们可以看到一个人笑了(见上图),我能让一只猫也笑起来,这是一个著名的 adaptation 问题。我们把人的笑脸转化到猫脸上,猫其实不会笑的,这是转化后的效果。这也是其中一个非常有趣的应用,也是 domain adaptation。

最后,人工智能这两年的进步非常巨大,非常震撼,让每一个研究人员、开发人员、创业者、企业的同事都觉得人工智能是将来。我也觉得人工智能路还很长,但是其中一个重要的方面,即我们怎么去把多种形态的信号、多种不同种类的输入结合起来,让机器得到对事情更加全面的分析,然后做出决策。这是在大数据或人工智能里面现在还远远未解决的问题。

我觉得,大家不要过分乐观,但是也不能过分悲观,这条路至少还要 10 年、20 年,甚至更长的路要走。我相信在这个过程中会诞生一系列有趣的工作、研究成果,甚至新的创业形式和产业形式。我希望大家对人工智能保持谨慎乐观的态度,之后在政府产业级的扶持下面,在公司及企业级的投入下面,还是会有新的产出出来。谢谢大家!

- PRCV 2021 | 视觉AI飞速发展,腾讯优图分享内容理解新实践

- AAAI2022腾讯优图14篇论文入选,含语义分割、图像着色、人脸安全、弱监督目标定位、场景文本识别等前沿领域

- AICon2021 | 腾讯优图鄢科:以AI技术助力内容安全 促进互联网环境健康发展

- 腾讯优图人脸安全能力再获认可!优图专家入选“护脸计划”专家委员会

- 腾讯优图斩获ICCV2021 LVIS Challenge Workshop冠军及最佳创新奖

- CCAI 2021 | 腾讯优图汪铖杰:用AI生成更优更新的内容

- 用AI技术开启穿越时空的视觉盛宴 腾讯优图亮相第八届世界互联网大会

- 腾讯优图“AI画廊”首次亮相2021重庆智博会展示智能技术前沿探索成果

- 腾讯优图17篇论文入选ICCV2021,含跨模态检索与分割、车辆识别等领域

- 腾讯优图荣获CVPR2021 Image Matching Workshop双赛道冠亚军

- 气味王国携手腾讯优图,登录2021世界人工智能大会

- 腾讯优图发布2021十大人工智能趋势,AI算法的公平性和隐私保护问题受关注

- 腾讯优图联合腾讯安全天御、微信共同推出侵权保护方案

- CVPR 2021 | 腾讯优图20篇论文入选,含人脸识别、时序动作定位、视频动作分割等领域

- 腾讯Light·公益创新挑战赛正式启动,腾讯优图用AI助力科技公益

- 刷新滤波器剪枝的SOTA效果,腾讯优图论文入选NeurIPS2020