专为AI推理而生的英伟达Tesla T4芯片

2018-09-22 12:00:16爱云资讯

图:望潮科技测评

深度学习技术以及其他机器学习技术已经大大提高了AI的声音识别和图片分类能力,并应用在越来越多的领域。

但,现阶段,深度学习技术更擅长做的是从大数据中找到线索,而不是理解这些数据,并得出结论。就好像深度学习能够识别出照片中的一只猫,但它不能“说出”猫的胡须、眼睛等具体信息,只能给出模棱两可的答案,甚至有可能将印有小猫图案的毛毯误认为一只猫。

也正因如此,随着机器学习行业趋于平衡,芯片厂商的关注点越来越多的转移到推理上。

作为全球三大芯片巨头之一,推理对于英伟达而言,一点也不陌生。其第一款基于GPU的推理引擎是Tesla M4和Tesla M40,它们发布于2015年。

两年前,英伟达推出专门针对机器学习推理的TeslaP4和P40加速器。两年后,它的升级版来了。

功耗更低,速度更快的Tesla T4

近日,英伟达CEO黄仁勋在东京发布最新一代专用于机器学习和数据推理的CPU Tesla T4。同时,英伟达表示,谷歌将率先将新款T4 GPU推向其云平台。

据悉,Tesla T4搭配TensorR T软件组成的新平台,主要面向AI应用,包括智能语音、翻译、视频、图像、推荐等应用领域,号称处理查询的速度比仅采用CPU时快了40倍,同时延迟更低。

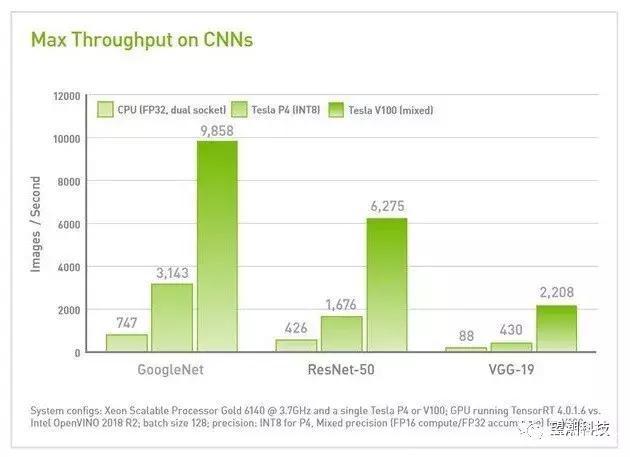

在运算速度上,英伟达表示T4明显快于P4。比如,在语音识别模型DeepSpeech 2上,T4比P4的5倍还要快;在神经网络翻译模型GNMT上,T4的速度接近P4的4倍;在图像识别模型ResNet-50上,T4也接近P4的3倍。

那T4快在哪里?

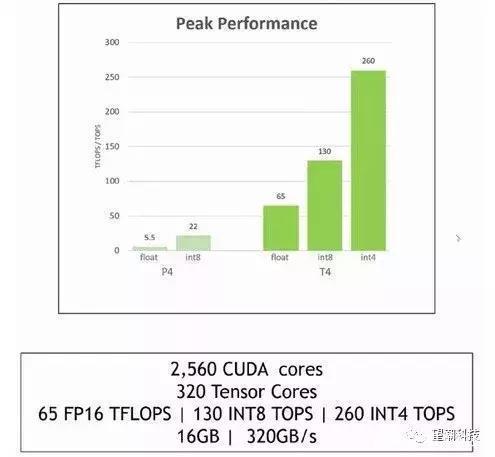

快在算力的增长。而决定T4算力增长的重中之重在于其图灵架构里的张量核心(Tensor Core)。T4内置了320个张量核心,这就让其数据吞吐量疾速增长,峰值达到260 TOPS(精度INT4) 。

然而,令人诧异的是,Tesla T4的功耗低的不可思议,整卡仅75W,无需辅助供电。而核心规模更小、计算性能更低的RTX 2070还要175-185W,显然这块卡在计算、功耗方面都做了特殊的优化!当然,也不能排除,这与RT光线追踪的耗电程度有关。

外观和内存

外观上,该卡采用了PCI-E扩展卡样式,全覆盖金属外壳,散热器隐藏在内部,整体极具质感也相当干练,同时因为面向计算领域而没有视频输出接口。

而在内存方面,其搭配了16GB GDDR6,双倍于游戏卡,不过带宽仅320GB/s,因此要么降低了位宽,要么降低了频率。

除了芯片以外,英伟达还将提供围绕T4的一系列技术,如用于优化深度学习模型的 TensorRT 软件,包括 TensorRT 推理服务器。TensorRT 是一个高度集成化的数据中心推理微服务,可以无缝插入现有的 Kubernetes 设施中。

推理工作负载将成为芯片厂商争夺的热门市场

事实上,专注于提升推理工作负载的性能,也是英伟达的一项战略举措。

据公司预计,未来五年,该市场将增长至200亿美元。与此同时,英特尔也声称,世界上大多数的推理工作负载,仍将运行在基于至强处理器的平台上。

鉴于当前英特尔占有全球约96%的服务器市场,这种说法还是相当可信的。并且,最近,英特尔还宣布在2017年为AI工作负载销售了10亿美元的处理器。预计未来几年,该数字还会迅速增长。

显然,推理工作负载将成为英伟达、英特尔、AMD 多家争夺的热门市场。

在这个市场上,作为老牌巨头,英特尔凭借的,是其在服务器市场的先发优势。而低成本、低功耗的推理加速器,如 Tesla T4,将对其发起每瓦特性能的巨大挑战。

据悉,AMD 也即将推出用于深度学习的 7nmRadeon Instinct GPU,谷歌也在积极开发自研的定制芯片,如 TPU。或许,在未来几年,我们能见证该领域的最终获胜者。

- 家用/商用全覆盖 A.O.史密斯AI-LiNK高端智慧互联惊艳亮相中国制冷展

- 生成式AI助力数字人“淘金热”,微美全息持续加码增强新增长动力

- 新华三徐润安:×AI的五次“运算”,加速基础架构走向AGI时代

- AI高性能专业工程师本——ThinkPad T14p AI 2024今日开售

- 国风文化+数智科技 AI+数智人视频彩铃引领全民阅读新潮流

- 联想周宝瑄:ThinkPad 思考·AI空间,让你感受“The Art of AI”艺术之美

- 51CTO邵燕:AIGC时代业技融合人才,赋能企业未来

- 小度CEO李莹:小度AI智能助手是有用、有灵魂的AI伙伴

- DEEPX将第一代AI芯片拓展至智能安防和视频分析市场

- 广州领芯RAID卡与浪潮信息云峦KeyarchOS完成澎湃技术认证

- 引领智能城市低碳转型 -- E Ink元太科技彩色电子纸全方位应用场景于2024Touch Taiwan展盛大展出

- 从“数字经济”到“AI+”,微盟《数字商业》为企业可持续增长指引方向

- 《开心消消乐》探索AI游戏革新,携手英特尔与腾讯云推动创新!

- 携单路最强“芯”,宝德4卡液冷图站PT6630W3助AIGC腾飞

- AI赋能出版新质生产力发展 蜜度承办人工智能与出版新质生产力论坛

- AI手机火爆推动麦克风量价齐升,瑞声科技等企业将领先受益