浪潮信息:互联网公司加速布局人工智能 AI服务器受追捧

2018-12-03 16:10:22爱云资讯

2018年,人工智能热度依然不减,可谓年度IT关键词之一,随着将人工智能上升为国家战略,我国的人工智能行业便如火如荼地展开。互联网行业和传统的制造业将经历一场大的变局,为了在这场变局中生存,各大互联网公司纷纷在人工智能方面布局,抢滩AI时代的制高点。

BAT三巨头有百度的自动驾驶,阿里的城市大脑,还有腾讯基于自己软件应用场景做的各种智能化尝试;新兴的人工智能巨头如科大讯飞的智能语音,今日头条的智能推荐等等,都在改变着人们的生活方式。而实现这一切的背后,离不开强大的AI服务器。

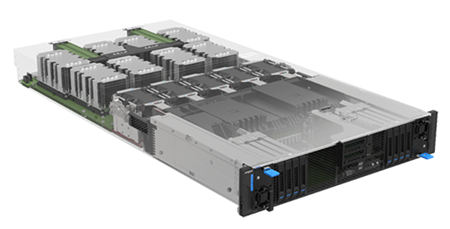

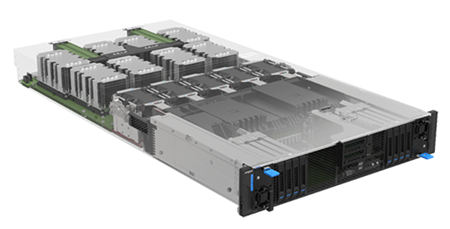

浪潮信息AGX-2(NF5288M5)是目前全球唯一可在2U空间支持8颗NVlink2.0高速互联GPU加速计算的AI服务器,能满足AI云、深度学习模型训练和线上推理等各类AI应用场景对计算架构性能、功耗的不同需求。每U搭载4颗GPU的密度、960TFlops的性能、ns级的延迟等强大性能的背后,必然对功耗、密度、稳定性带来极大的挑战,这背后又有哪些黑科技呢?

AI计算加速器AGX-2

为了提升计算效率、满足多样化AI场景需求,AGX-2变异构为同构,消除了异构通信带来降低计算效率的烦恼。为了更大幅度地提升服务器计算效率,满足AI应用对计算力的需求,AGX-2在架构设计中将计算密度做到了极致。而为了满足客户对弹性架构平台的需求,AGX-2创新地采用PCI-E连接资源,实现更加灵活的拓扑。

浪潮信息AI服务器 AGX-2

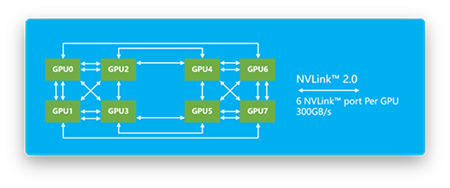

极致效率、异构变同构:AGX-2抛弃传统异构计算架构模式,在2U空间内支持部署8块NVLink或PCI-E 接口的NVIDIA? Tesla? P100 GPU,可以在不依赖CPU的前提下,实现机内点到点通讯,减少了异构通讯的次数;并在业界率先支持NVLink 2.0和最新发布的NVIDIA? Tesla?系列GPU,可以实现GPU间高达300GB/s的互连带宽,并提供极低的延迟,让多块GPU并行的效率大幅提升超过60%。将GPU同构,把AGX-2的并行计算效率尽可能推到极限。

极致密度、更高计算力:与浪潮信息支持2U4卡的NF5288M4对比测试,AGX-2采用P100的Linpack浮点运算性能达29.33TFLOPS,是同样采用P100 NF5288M4的2.47倍;在AI深度学习模型训练上,当采用TensorFlow框架和

GoogLeNet模型,AGX-2处理速度为每秒1165幅图片,是搭配4片Tesla? M40的NF5288M4性能的2.49倍。在实现了性能和效率双提升的同时,机箱仍然保持了和上一代一样的2U高度,实现了最高的GPU卡部署密度。在超大规模AI训练集群或HPC集群引用时,可以帮助客户节省数据中心的基础设施资源,更有利于数据中心的空间分配。

极致灵活、弹性计算拓扑:AGX-2采用PCI-E线缆的方式连接CPU和GPU资源,可以灵活调整CPU的连接带宽和连接数量,在应对不同的AI应用时,更好的做到PCI-E资源按需分配。灵活的计算架构可以让一颗或两颗CPU管理8颗GPU,也可以通过GPU扩展box的方式,实现最大16GPU的纵向扩展。而服务器提供的PCI-E I/O,8个U.2插槽, 或多达4块100Gbps InfiniBand网卡,都可以根据计算灵活调整拓扑。AGX-2弹性的异构平台,足以支撑多样化的AI场景。

极致设计背后带来的极限挑战

AGX-2通过优秀的设计,实现了性能、灵活性和密度的多维度增强,然而这背后带来的却是对互连、供电和散热设计的三大极限挑战。如何在一个系统中实现GPU卡的灵活配置,满足高达3000W的供电需求,并在有限的空间内解决散热,成为了开发这款产品的三大难题 。在此就给大家一一揭秘AGX-2是如何做到的。

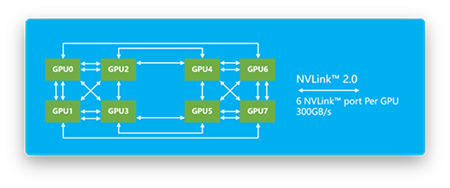

300GB/s聚合带宽的Cube Mesh拓扑

互连挑战:有别于业界异构服务器CPU和GPU紧耦合的互连方式,AGX-2采用解耦式设计,不但提供灵活性,同时还支持高达300GB/s的NVIDIA? NVLink?GPU互连带宽。浪潮信息

结合刀片服务器的设计思路,把这些组件紧凑的布局到2U空间中,并基于8路服务器的设计经验,确保NVLink?的走线长度、信号都处在最佳状态,以保证GPU的性能发挥。

供电挑战:8块功耗高达300W的GPU,以及服务器内其他的计算、存储和I/O资源,整机的功耗需求达到3000W,供电如何走线成为最大的挑战。AGX-2借鉴了浪潮信息在整机柜服务器的供电设计方式,对单服务器内部采用无线缆供电设计,减少了供电线缆对空间的占用以及对散热气流的影响。在保证供电能力的同时,对空间、散热的影响降到最低。

散热挑战:3000W的供电,意味着3000W的峰值发热量,6倍于传统的2U服务器,散热成为一个绕不过的难题。AGX-2在设计之初,从布局、风道和气流多个方面统筹进行考虑。低发热量组件前置,高发热量组件后置,避免局部热点,让空气在服务器的内部均衡的升温,再通过高速风扇将热量快速带出服务器,最终AGX-2可以和传统服务器一样工作在35℃的环温下。并且为了支持低PUE数据中心,还可以配置气液混合散热,甚至可以支持45℃的高环温运行。

100%的计算密度提升、960TFlops的计算力、200倍的单机AI训练性能,AGX-2无愧是一款最高密度、最高性能的AI服务器,无论是在面向人工智能训练还是HPC应用时,都将为用户提供极致性能体验。和传统概念的高性能集群相比,GPU同构、灵活拓扑和超高密度的整体架构,让应用和硬件的结合,变得更为高效和紧密。

BAT三巨头有百度的自动驾驶,阿里的城市大脑,还有腾讯基于自己软件应用场景做的各种智能化尝试;新兴的人工智能巨头如科大讯飞的智能语音,今日头条的智能推荐等等,都在改变着人们的生活方式。而实现这一切的背后,离不开强大的AI服务器。

浪潮信息AGX-2(NF5288M5)是目前全球唯一可在2U空间支持8颗NVlink2.0高速互联GPU加速计算的AI服务器,能满足AI云、深度学习模型训练和线上推理等各类AI应用场景对计算架构性能、功耗的不同需求。每U搭载4颗GPU的密度、960TFlops的性能、ns级的延迟等强大性能的背后,必然对功耗、密度、稳定性带来极大的挑战,这背后又有哪些黑科技呢?

AI计算加速器AGX-2

为了提升计算效率、满足多样化AI场景需求,AGX-2变异构为同构,消除了异构通信带来降低计算效率的烦恼。为了更大幅度地提升服务器计算效率,满足AI应用对计算力的需求,AGX-2在架构设计中将计算密度做到了极致。而为了满足客户对弹性架构平台的需求,AGX-2创新地采用PCI-E连接资源,实现更加灵活的拓扑。

浪潮信息AI服务器 AGX-2

极致效率、异构变同构:AGX-2抛弃传统异构计算架构模式,在2U空间内支持部署8块NVLink或PCI-E 接口的NVIDIA? Tesla? P100 GPU,可以在不依赖CPU的前提下,实现机内点到点通讯,减少了异构通讯的次数;并在业界率先支持NVLink 2.0和最新发布的NVIDIA? Tesla?系列GPU,可以实现GPU间高达300GB/s的互连带宽,并提供极低的延迟,让多块GPU并行的效率大幅提升超过60%。将GPU同构,把AGX-2的并行计算效率尽可能推到极限。

极致密度、更高计算力:与浪潮信息支持2U4卡的NF5288M4对比测试,AGX-2采用P100的Linpack浮点运算性能达29.33TFLOPS,是同样采用P100 NF5288M4的2.47倍;在AI深度学习模型训练上,当采用TensorFlow框架和

GoogLeNet模型,AGX-2处理速度为每秒1165幅图片,是搭配4片Tesla? M40的NF5288M4性能的2.49倍。在实现了性能和效率双提升的同时,机箱仍然保持了和上一代一样的2U高度,实现了最高的GPU卡部署密度。在超大规模AI训练集群或HPC集群引用时,可以帮助客户节省数据中心的基础设施资源,更有利于数据中心的空间分配。

极致灵活、弹性计算拓扑:AGX-2采用PCI-E线缆的方式连接CPU和GPU资源,可以灵活调整CPU的连接带宽和连接数量,在应对不同的AI应用时,更好的做到PCI-E资源按需分配。灵活的计算架构可以让一颗或两颗CPU管理8颗GPU,也可以通过GPU扩展box的方式,实现最大16GPU的纵向扩展。而服务器提供的PCI-E I/O,8个U.2插槽, 或多达4块100Gbps InfiniBand网卡,都可以根据计算灵活调整拓扑。AGX-2弹性的异构平台,足以支撑多样化的AI场景。

极致设计背后带来的极限挑战

AGX-2通过优秀的设计,实现了性能、灵活性和密度的多维度增强,然而这背后带来的却是对互连、供电和散热设计的三大极限挑战。如何在一个系统中实现GPU卡的灵活配置,满足高达3000W的供电需求,并在有限的空间内解决散热,成为了开发这款产品的三大难题 。在此就给大家一一揭秘AGX-2是如何做到的。

300GB/s聚合带宽的Cube Mesh拓扑

互连挑战:有别于业界异构服务器CPU和GPU紧耦合的互连方式,AGX-2采用解耦式设计,不但提供灵活性,同时还支持高达300GB/s的NVIDIA? NVLink?GPU互连带宽。浪潮信息

结合刀片服务器的设计思路,把这些组件紧凑的布局到2U空间中,并基于8路服务器的设计经验,确保NVLink?的走线长度、信号都处在最佳状态,以保证GPU的性能发挥。

供电挑战:8块功耗高达300W的GPU,以及服务器内其他的计算、存储和I/O资源,整机的功耗需求达到3000W,供电如何走线成为最大的挑战。AGX-2借鉴了浪潮信息在整机柜服务器的供电设计方式,对单服务器内部采用无线缆供电设计,减少了供电线缆对空间的占用以及对散热气流的影响。在保证供电能力的同时,对空间、散热的影响降到最低。

散热挑战:3000W的供电,意味着3000W的峰值发热量,6倍于传统的2U服务器,散热成为一个绕不过的难题。AGX-2在设计之初,从布局、风道和气流多个方面统筹进行考虑。低发热量组件前置,高发热量组件后置,避免局部热点,让空气在服务器的内部均衡的升温,再通过高速风扇将热量快速带出服务器,最终AGX-2可以和传统服务器一样工作在35℃的环温下。并且为了支持低PUE数据中心,还可以配置气液混合散热,甚至可以支持45℃的高环温运行。

100%的计算密度提升、960TFlops的计算力、200倍的单机AI训练性能,AGX-2无愧是一款最高密度、最高性能的AI服务器,无论是在面向人工智能训练还是HPC应用时,都将为用户提供极致性能体验。和传统概念的高性能集群相比,GPU同构、灵活拓扑和超高密度的整体架构,让应用和硬件的结合,变得更为高效和紧密。

相关文章

- 华为首款开放式耳机正式发布,创新C形设计引领科技时尚新浪潮

- 统信软件多款产品与KeyarchOS完成浪潮信息澎湃技术认证

- 浪潮信息G7服务器全面支持第五代英特尔®至强®可扩展处理器

- CHS2023丨神州医疗许娟:AI浪潮下的医疗大模型突破与创新

- 内嵌混合AI算力+增强AI+体验升级,ThinkPad X1 Carbon AI引领AI PC浪潮

- 清流资本十周年特别行动:CEO闭门会系列之“拥抱新AI+新智造浪潮”专场

- 信创浪潮下,蓝科LucaNet如何助力企业财务实现数字化跃升

- IDC: 浪潮信息居全球服务器份额第二

- 2024 信心满满!19家元脑生态伙伴与浪潮信息签署亿元分销协议

- 高通孟樸:在新一轮5G+AI创新浪潮下,携手产业共建数字化未来

- 中控技术发布InPlant SCADA 2024新版本:免费授权加速组态软件发展浪潮

- 浪潮信息刘军:智算力系统创新 加速生成式AI产业发展

- 高通陈雷:新一轮5G浪潮推动绿色低碳经济发展

- AGI引领智能升级浪潮,微美全息布局高增长领域书写AI行业发展前沿

- 迎数贸浪潮,信天金钗石斛与数字未来共健康

- 浪潮信息赵帅:实现算力全流程绿色化,推动数据中心可持续发展

热门文章

头条文章

重点文章

推荐文章

热点文章