首次商用试运行,类脑智算集群支持大模型快速推理服务

2025-08-14 14:16:40AI云资讯2486

据悉,“杭州灵汐类脑智算集群”已于7月底实现了大模型快速推理API的企业服务试运行。该集群由杭州灵汐类脑科技有限公司牵头搭建运营,中国电信、中国电子科技南湖研究院以及脑启社区作为合作方参与,由杭州电信具体承担集成建设。该集群部署在中国电信杭州智算中心,算力规模超200POPS。这也是类脑智算集群在全球范围内,首次以支持大模型快速推理的方式,走向商用试运行。

作为类脑智能技术的创新应用成果,该智算集群具有”存算一体、众核并行、稀疏计算、事件驱动”的特性,可显著提升计算效率、大幅降低能耗,实现大语言模型推理的“一快、一低、一降”:一是推理速度快,单用户的推理延迟控制在毫秒级别,速度性能相对于传统方案有明显优势(可流畅响应实时交互及长本文深度推理),告别卡顿;二是首token延迟低,可降至百毫秒乃至十毫秒级;三是智算集群的功耗大幅下降,较业界同等推理算力水平可降低功耗二分之一至三分之二以上。异构融合类脑芯片具有兼容PyTorch框架的类CUDA软件栈,可直接服务于多类开源大模型的快速推理、而不需要转换类脑算法。

图1灵汐智算平台大模型登录

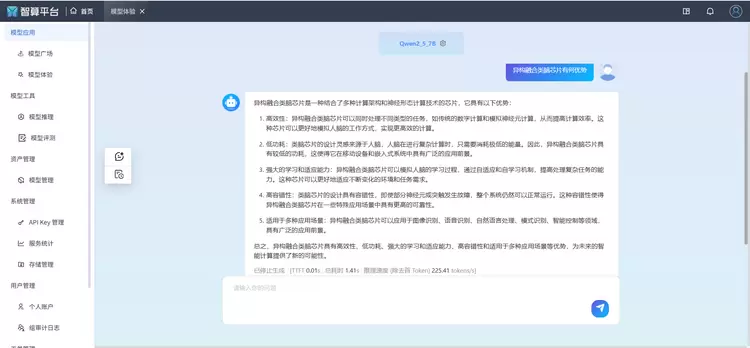

图2灵汐智算平台大模型快速推理

当前,大模型推理普遍存在吞吐速度慢(每秒十到几十词输出)和高延迟问题(常常超过1秒甚至数秒),对众多行业场景构成了制约。在此背景下,灵汐科技基于类脑智能技术给出了“高实时、高吞吐、低延迟“的推理服务解决方案,将在金融应用、情感陪聊、快速导览、大规模数据标注以及无人机实时航拍处理、灾害预警与应急处置等领域场景逐步落地。据介绍,该智算集群(中心)将持续升级,新一代类脑智算高密度计算平台也将在近期正式发布推出,集群能效比预计将进一步提升。

相关文章

- 四通集团携手云酷智能全球首发RTX5090浸没式智算解决方案,开启绿色算力浸时代

- 九章云极智算云:以普惠算力重塑高校AI科研生态

- 200kW高密模块、1.2MW UPS,能把智算中心的痛点一次性打穿吗?

- 筑牢智算基石 赋能数字未来 九章云极DataCanvas入选《“AI中国”生态图谱(2025)》

- 异构智算 本地引擎|联想携“四大”重磅发布,构建标准化体系,加速AI工厂落地

- Forrester报告:九章智算云凭普惠算力登顶亚太首位

- AI新云破局与算力普惠:中国智算产业的2025分水岭

- AI 生态重构正当时,联通云如何以“算网一体”撬动国产智算新局?

- 强强联合!天数智芯与特斯联携手打造AIoT混合智算底座

- 量子湃——深圳天顿数据科技有限公司旗下一站式智算服务平台!

- 冀·录|从“走廊明珠”到“智算高地”,廊坊智算中心厚植京津冀算力“后花园”

- 基石智算国际版正式上线,为全球开发者提供大模型API服务

- 算力狂奔,综合布线如何铸就AI网络底座?Aginode安捷诺深度解析智算中心网络趋势

- 深度智控亮相2025数据中心标准峰会:发布智算数据中心全链路能效智控方案

- 全球智慧 全链驱动|CDCC维谛专场:解码AI 2.0时代的智算基础设施升级路径

- 华为擎云亮相2025世界计算大会,赋能行业智算驱动

人工智能企业

更多>>人工智能硬件

更多>>人工智能产业

更多>>人工智能技术

更多>>- 百度千帆深度研究Agent登顶权威评测榜单DeepResearch Bench

- 在MoltBot/ClawdBot,火山方舟模型服务助力开发者畅享模型自由

- 教程 | OpenCode调用基石智算大模型,AI 编程效率翻倍

- 全国首个!上海上线规划资源AI大模型,商汤大装置让城市治理“更聪明”

- 昇思人工智能框架峰会 | 昇思MindSpore MoE模型性能优化方案,提升训练性能15%+

- 媲美DeepSeek NSA!腾讯优图提出混合注意力机制SSA,长上下文外推更强

- SOTA达成!腾讯优图D-Search算法登顶国际AI权威榜单

- 智象未来团队荣获ACM Multimedia 2025最佳演示奖,多模态生成式AI技术领跑全球