讯飞输入法随心说 中英、七大方言混合语音输入无压力

2019-01-24 16:45:28爱云资讯

都说2018是人工智能(AI)应用元年,遥不可及的AI与大众的关系变得越来越亲密。2018年4月,讯飞输入法发布了全语音交互的“莫得键盘”;6月AI赋能,使通用语音识别率提升至98%,支持20多种方言语音输入,实现语音识别、语音合成以及机器翻译的场景融合,提升语音输入的表达力。经过半年时间的创新和沉淀,讯飞输入法语音输入又有了新突破,最新Android版本支持中英混合语音输入『随心说』,同时优化普通话与方言口音的混合语音输入效果,增强了语音输入体验。

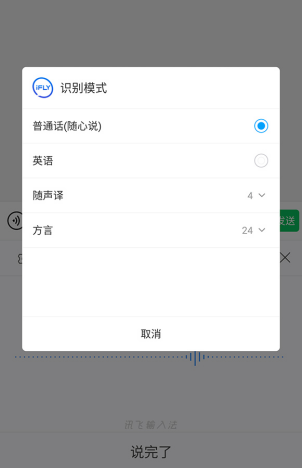

有没有发现,职场工作的你时不时说中文夹杂英文。放假回家,Amanda又秒变彩凤,前一句普通话后一句家乡话脱口而出!常见的语音输入是这样的,上班谈事说英文切换到英文识别模式;回家跟亲朋友好友在线聊天,说家乡话切换到对应的方言模式。如果想在沟通中做到“雅俗共赏”,那需要手动切换起来,中→英,英→中,普通话→方言,方言→普通话,英→方言,频繁操作体验自然不尽如人意。

日前讯飞输入法上线语音输入『随心说』,不用切换语音识别模式就能实现中英混合语音输入。据悉,为更好助力方言口音的表达,进一步优化了包括东北话、天津话、河南话、皖北话、山东话、河北话、四川话七种方言与普通话的混合语音输入效果。“准确输入”、“高效表达”、“便捷交互”、“智能识别”基于这些关键词,可以看出讯飞输入法技术能力快速迭代,同时也是科大讯飞AI核心技术不断赋能的体现。

事实上,科大讯飞在AI研究和应用,特别是智能语音方面布局多年。基于注意力模型的核心思想,通过机器学习的方法,构建了Hybrid CNN模型,用于构建语音识别声学模型的全局优化,堪称目前效果更好、资源占用更小、模型更灵活的语音识别框架。

具体来说,在原DFCNN基础上,将传统卷积使用扩张卷积代替,从而实现对语音长时相关性的更精确的表达。与此同时,还引入基于长短期记忆网络LSTM的门控机制使得Hybrid CNN在长时相关性建模的过程中,能快速的过滤噪声等干扰信息,并加强语境等长时信息,颇具灵活性,从而在实际应用中能够保障高噪声等复杂场景的语音识别效果。

另外,Hybrid CNN模型真正实现了端到端的建模,以原始音频波形直接建模,避免了人工设计的特征提取过程带来的信息损失,真正的实现了端到端建模,进一步提升识别效果。

也正因为上述的创新,使Hybrid CNN这种前沿的语音识别框架克服了DFCNN模型参数量和计算复杂度大的问题。在保证识别效果不损失的情况下,系统资源占用规模和运算量同比下降了60%以上,使得Hybrid CNN可以在手机等设备上流畅的运行,这也使得本地化语音的识别效果更加接近云端识别效果。

A.I.持续赋能讯飞输入法,不仅提高手机输入效率和准确率,甚至免去语音识别的切换操作,让用户享受A.I.带来的全新便捷生活。

- 第五站活动将打响!讯飞智能办公本带用户探访制造新标杆

- 科大讯飞人工智能赋能司法事业,讯飞智能录音笔全程助力

- 科大讯飞刘庆峰:通用人工智能就是数字时代的“原子弹”,中国必须得有自己的

- MWC 2024 | 科大讯飞受邀参加GTI国际产业大会5G新通话产业发展论坛

- 讯飞智作亮相世界移动通信大会

- 科大讯飞首次亮相MWC巴塞罗那,自研AI国货赋能世界连接

- 讯飞输入法AI助手高情商沟通 拜年祝福走心有新意

- 一路奔赴 科大讯飞给凉山孩子送AI学习机作为新年礼物

- 讯飞双屏翻译机即将首发语音大模型,多语言自动识别重磅亮相

- 讯飞星火能力跃升!科大讯飞AI学习机持续释放大模型潜能!

- 讯飞星火V3.5发布:开发者生态超35万 应用加速落地

- 讯飞星火认知大模型3.5升级发布 讯飞输入法AI能力再提升

- 科大讯飞联合中国移动推出5G新通话创新应用“商务速记”

- 星火语音大模型首发 讯飞输入法AI能力将获提升

- 讯飞输入法获2023NextWorld年度风采奖 亮相纽约时代广场大屏

- 科大讯飞智能办公本 X3:大模型赋能,新年送礼好选择