Google AI再定义设备端机器学习,DNNs智能手机端实现实时运行

2019-05-15 11:14:36AI云资讯785

使用YOPO的最大原则加速对抗训练

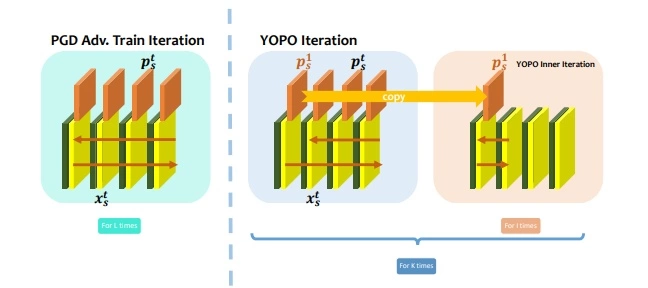

在YouOnly PropagateOnce(YOPO)的算法中,研究人员开发了出一种加速对抗训练的有效策略。他们将神经网络的对抗训练重新组织为差异化游戏,并为其开发了庞特里亚金(Pontryagin)的极大原则。

通过最大原理,他们发现对抗层只与第一层的权重相结合,这有助于将对抗层更新从反向传播梯度计算中分离出来。

这样做,YOPO避免了访问梯度所需的次数,这显著减少了计算时间。为了证明其有效性,研究人员在MNIST和CIFAR10上进行了实验,并发现使用YOPO训练的模型与PGD对抗训练的模型在清洁数据和对抗扰动数据上具有相似的表现,但YOPO训练的模型具有更优秀的性能和较低的计算成本。

YOPO让人联想到YOLO,但与YOLO不同的是,YOPO算法是解决庞特里亚金极大原理的一种方法。庞特里亚金的极大原理具有很大的潜力,因为它可以启发各种算法的设计,从而分解对抗更新和数据反向传播。

我们希望YOPO能够为强大的ML应用程序修复对抗性示例。

如果你发现了对抗性示例,恭喜你,从现在开始它们不再是bug

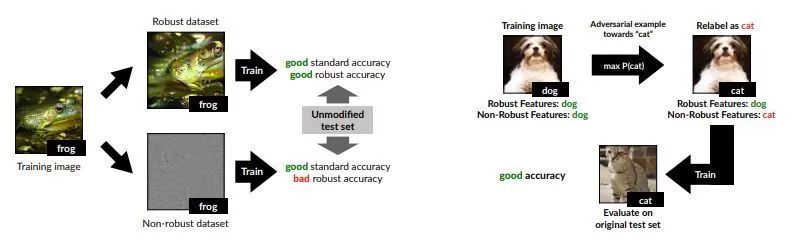

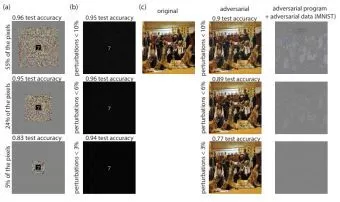

与传统观点相反,一群学者最近发表了一种关于对抗性示例现象的新观点。根据他们的说法,对抗性的示例自然地来自于标准机器学习数据集中的高度预测但非鲁棒的特征。

他们证明了对抗性的示例可以直接归因于非鲁棒特征的存在。非鲁棒特征意为从数据分布的模式中得到的具有高度预测性的特征,但这对人类来说是脆弱和难以理解的。

他们将对抗脆弱性作为主导监督学习范式的主要结果,这表明:对抗脆弱性是我们模型对数据中良好概括特征的敏感性的直接结果。

他们通过明确地解释标准数据集中鲁棒的和非鲁棒的特征,为他们的假设提供了支持。此外,他们表明单独的非强大功能对于良好的推广是令人满意的。

本研究论文中的研究结果似乎得出结论,只有在采用鲁棒训练时,分类器才能学习完全准确且完全稳健的决策边界。因此,鉴于这些元素存在于真实世界的数据集中,分类器利用在人类选择的相似概念下恰好是非鲁棒的高度预测特征应该不足为奇。

此外,从可解释性的角度来看,只要模型依赖于非鲁棒特征,就不可能期望模型解释既对人类有意义又完全依据模型。为了获得可解释和强大的模型,需要人类进行先验后,再进行模型训练。

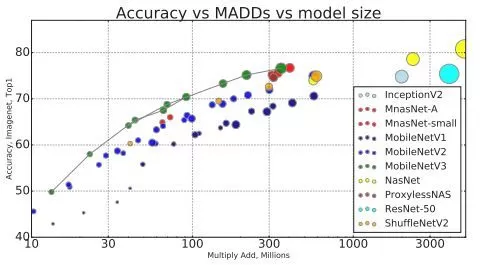

下一代MobileNetV3定义

2017年,GoogleAI宣布发布了MobileNets,这种计算机视觉模型旨在于考虑设备或嵌入式应用程序资源受限的情况下,有效并最大限度地提高准确性。现在,研究人员发布了MobileNetV3,它代表了基于互补搜索技术和新架构设计相结合的下一代MobileNets。

MobileNetV3通过结合使用NetAdapt算法补充的硬件感知网络架构搜索(NAS)调整到移动电话CPU,然后通过尖端架构改进进行性能提升。

在此过程之后,研究人员创建了两个新的MobileNet模型:MobileNetV3-Large和MobileNetV3-Small,分别针对高资源和低资源的使用情况。然后对模型进行调整并应用于对象检测和语义分割任务。

MobileNetV3的大型和小型模型将使研究人员能够继续进步,从而提供下一代高度精确的网络模型,这将促进设备端计算机视觉的进步。

半监督学习的整体性方案

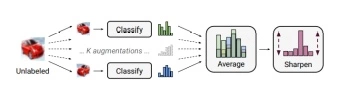

半监督式学习已经证明,它是利用未标记的数据来减轻机器学习对大型标记数据集依赖的一种强有力的方法。谷歌的一组研究人员已经通过对目前领先的半监督学习方法的整合而提出了一种新的算法,即MixMatch.新算法的工作原理是通过猜测新增未标记数据的低熵标签并通过MixUp混合已标记和未标记数据.

评估显示,MixMatch在许多数据集和标记的数据量等方面极大地显示了其优越性.例如,在有250个标签的CIFAR-10,STL-10的系数为2的情况下上,错误率从38%下降到了11%

MixMatch展现出其相对于传统方法的优越性.这一研究更有价值的一点在于对半监督学习文献和相关混合方法研究的进一步整合,这讲促进对大幅提高算法效率因素的探索。

目前,MixMatch可以帮助我们实现更好的差别隐私交易中的准确性和私密性。

针对神经网络的对抗式再编程

在近期的研究中,谷歌研究员尝试了一个具有挑战性的目标:在不提供攻击者对既定目标期望输出的条件下,重新编程来模拟攻击者选择的任务。

研究人员发现,经过训练的神经网络可以被重新编程来分类排列的图像,这些图像不保留任何原始的空间结构,这表明跨领域重新编程是可能的。他们还发现,经过训练的神经网络比随机系统更容易受到对抗式重新编程的影响,即使在数据结构与主要任务中的数据结构差异很大的情况下,重新编程仍然是成功的。

这就是对图像领域中的分类任务进行对抗式重新编程的演示。类似的攻击在音频、视频、文本或其他方面能成功吗?以RNNs的对抗式重新编程为例——攻击者只需要在RNN中找到用于执行简单操作的输入,就可以重新编程模型来执行任何计算任务。

如果一个特别设计的输入可以重构整个机器学习系统,攻击者将会达到难以预料的可怕效果。例如,攻击者很容易窃取计算资源或执行违反云服务编程的任务。所有这一切都表明了对抗式重新编程可能给人工智能系统带来的潜在威胁。

随着人工智能的不断发展,认识到技术的进步可能带来的潜在挑战,并努力找到减轻或抵御这些挑战的可能方法,对人工智能的未来十分重要。

相关文章

- Google发布AI领域新进展:涉及抗灾、生成式AI和语言模型

- Google Pixel Fold显示屏规格曝光

- Aqara绿米亮相Google I/O大会,支持Matter协议助力智能家居互通互联

- Google发布搭载Tensor处理器的Pixel 6a 售价449美元

- Google正在使用人工智能“更准确地检测更广泛的个人危机搜索”

- 飞书深诺荣膺三项Google 2021年优秀合作伙伴大奖,在出海营销机构中独占鳌头

- 神州数码旗下GoPomelo荣获Google Cloud年度合作伙伴大奖

- Google推出第四代定制AI芯片TPU v4

- Google AI再曝黑人女员工离职,这是所有科技公司都将面对的问题

- Google实验允许“听到颜色的声音”

- 谷歌开发的双击手势操作 可触发Google Assistant

- VR/AR大战或一触即发,苹果/Google/微美全息等布局5G商用的竞速赛

- 取代Android TV!谷歌或在3月推出全新的Google TV

- 诺基亚与Google签约以构建基于云的5G网络

- Google和苹果,为什么都想让你安装新系统

- Google最新的AR化妆功能曝光,微美全息AR+AI人脸识别精确解锁