百度ERNIN获国际权威数据集GLUE最高分 《麻省理工科技评论》点赞

2019-12-30 15:19:31AI云资讯1422

12月26日,全球顶级科技商业杂志《麻省理工科技评论》(MITTechnologyReview)英文官方网站报道称,百度预训练模型ERNIE超越微软和谷歌获得自然语言处理领域权威数据集GLUE最高分。《麻省理工科技评论》指出,GLUE测试的满分为100分,人类的平均得分大概在87分左右,百度ERNIE则是在业界首次突破了90分。百度的成就能够表明多样化的贡献参与将有助于推动人工智能研究。

通用语言理解评估基准GLUE是自然语言处理领域最权威的排行榜之一。此前,自然语言模型擅长预测即将出现的下一个单词,自动完成拼写,但却无法理解一个小段落的连续思路。因为这些模型不能理解句子的意思,弄不清楚句子中代词的指代关系。2018年底,谷歌推出BERT,使用“掩码”技术更精准预测文本段落的含义。

但中文语境中,人工智能对自然语言理解更难。相较于英语里的一个单词代表一个含义,中文词语由多个汉字组成,单个汉字在不同词中又具备不同含义。比如灵,可以是机灵,也可以是灵魂。

2019年3月,百度发布NLP模型ERNIE破解了这一难题,通过ERNIE持续学习框架进一步优化了通用词汇级知识学习和面向任务类型的预训练,使得ERNIE能够掌据中文汉字构成词汇的方法,也更能准确预测出缺失的语句内容。而且,研究人员发现ERNIE在英语中也有更好的效果。

《麻省理工科技评论》指出ERNIE的重要意义不止于此,因其采用了连续培训的方法,在培训新数据和新任务的同时又不会遗忘已经积累的知识。如此,在不怎么需要人工干预的情况下,就能够越来越好的执行更广泛的任务。

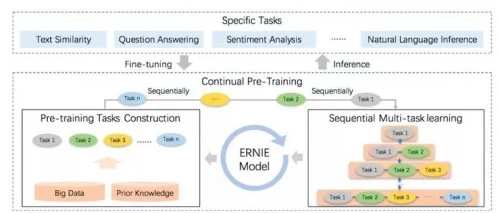

短短4个月后,ERNIE再度升级。ERNIE 2.0持续学习的语义理解框架发布, 可支持增量引入不同角度的自定义预训练任务,通过多任务学习对模型进行训练更新,每当引入新任务时,该框架可在学习该任务的同时,还可牢记以前学到过的信息。此外,ERNIE 2.0在16项中英文任务上超越了 BERT 和 XLNet,取得SOTA效果。据悉,百度ERNIE 2.0的论文已被国际人工智能顶级学术会议AAAI-2020收录,将于2020年2月面向行业公开展示。

(百度ERNIE 2.0原理示意图)

从研发到落地应用,从实现中文场景的突破到2.0版本的惊人表现,ERNIE屡创佳绩背后离不开百度飞桨的长期产业实践积累的高效率GPU分布式训练能力。飞桨的分布式训练能够在相同硬件设备的情况下,大大缩短产品迭代周期,满足深度学习模型对训练速度的高要求。目前,ERNIE预训练技术已广泛地应用于百度内外多个产品和技术场景,在百度搜索、小度音箱、信息流推荐等一系列产品应用中发挥了重要作用。

ERNIE世界性成果引发的国际媒体关注,也是中国自研技术领先业界的一个缩影。未来,将有越来越多ERNIE这样的中国科技、百度这样的中国企业,持续输出中国AI的“战斗值”

相关文章

- 百度商家智能体对话近450万次,数字人线索直播助力商家转化率涨三成

- 500万用户追捧!百度地图岳云鹏文心AI副驾对话破亿,春节互动数据亮眼

- 白龙马变身文心AI副驾?岳云鹏携手百度地图上天津春晚,送出2亿红包!

- MongoDB与百度智能云达成战略合作,打造全球领先的AI原生数据库生态

- 百度百科推出国际版BaiduWiki,正式迈入全球化知识服务阶段

- Omdia报告:百度智能云领跑中国具身智能AI云市场

- 《运输策略蓝图》发布 百度杨楠:香港是孵化自动驾驶业务的宝地

- 百度千帆启动开发者大使计划 携手行业先行者共建Agent繁荣生态

- 诺科达智驾亮相百度 Apollo 生态大会,荣获 2025 年度杰出应用奖

- 百度千帆深度研究Agent登顶权威评测榜单DeepResearch Bench

- 手机也能用OpenClaw了!百度智能云发布移动端接入方案

- 以“高效现场 AI”回应产业升级需求 DEEPX 在百度 Moment 2026 展示 Physical AI 产业化实践成果

- 百度YY启动“熊力·聚星计划”携手刘天池选拔短剧新星

- 百度地图刘增刚:百度地图致力于成为AI时代的入口与基建

- 生态融合赋能出行 荣耀MagicOS携手百度地图共创智慧体验新高度

- Questel报告:百度大模型专利申请量全球第一,智能体、数字人专利申请量国内第一

人工智能企业

更多>>人工智能硬件

更多>>人工智能产业

更多>>人工智能技术

更多>>- 云知声Unisound U1-OCR大模型发布!首个工业级文档智能基础大模型,开启OCR 3.0时代

- 基石智算上线 MiniMax M2.5,超强编程与智能体工具调用能力

- 昇腾原生支持,科学多模态大模型Intern-S1-Pro正式发布并开源

- 百度千帆深度研究Agent登顶权威评测榜单DeepResearch Bench

- 在MoltBot/ClawdBot,火山方舟模型服务助力开发者畅享模型自由

- 教程 | OpenCode调用基石智算大模型,AI 编程效率翻倍

- 全国首个!上海上线规划资源AI大模型,商汤大装置让城市治理“更聪明”

- 昇思人工智能框架峰会 | 昇思MindSpore MoE模型性能优化方案,提升训练性能15%+