更快更好的实时AI,英伟达TensorRT 8让时延与精度不纠结

2021-07-20 21:34:13AI云资讯868

性能精度均提升2倍

一直以来,英伟达在AI领域的布局都不止于硬件,TensorRT就是重要佐证之一,作为用于高性能深度学习推理的SDK。此SDK包含深度学习推理优化器和运行时环境,可为深度学习推理应用提供低延迟和高吞吐量。

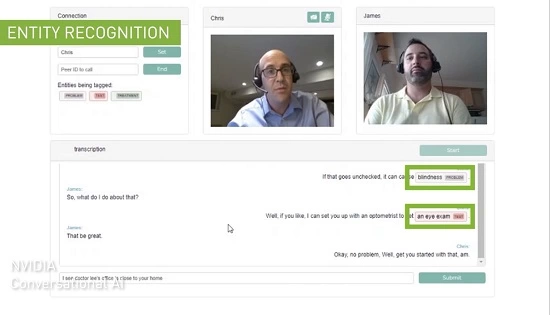

通过TensorRT,开发者可将TensorFlow、Pytorch等训练好的框架模型,通过优化后良好的运行在英伟达的GPU上。在2019年发布的NVIDIA TensorRT 7已经为智能的AI人际交互打开了大门,可实现与语音代理、聊天机器人和推荐引擎等应用的实时互动。

TensorRT 7配合A100 GPU可实现在2.5毫秒内运行BERT-Large,此次新发布的TensorRT 8将时间缩减至1.2毫秒。作为目前最广为采用的基于transformer的模型之一,意味着理论上当用户在使用如实时语音翻译这样的功能时,TensorRT 8的处理延迟时间可降至1.2毫秒。

TensorRT 8相比TensorRT 7有着两倍性能提升的同时,精度也同样提升2倍。TensorRT 8在两方面实现了AI推理上的突破,一方面提升了对于英伟达Ampere架构GPU的稀疏性,在提升效率的同时还能减少开发者加速神经网络时的计算操作。另一方面是量化感知训练,开发者能够使用训练好的模型,以INT8精度运行推理,在这一过程中不会损失精度。

这就意味着,企业可以将模型扩大1-2倍,实现精度的大幅提升,让自身的实时AI应用变得又快又好。

为多领域带来更快更好的AI能力

当前,TensorRT的生态影响力正在快速增长,2020年的开发者人数相比2019年就实现了3倍的增长,达到35万人,下载量已经达到近250万次,共有从边缘到云的多个领域的共27500家公司加入到该生态之中。其中包括如电信运营商Verizon,也有国内的知名互联网公司阿里、腾讯、字节跳动等。

TensorRT 8的发布无疑将会让搜索、购物推荐、语音翻译、语音转文字这样的AI应用能够实现更快更好。Hugging Face就正在与英伟达开展密切合作,作为大规模AI服务提供商,Hugging Face加速推理API能够为基于NVIDIA GPU的transformer模型提供高达100倍的速度提升,通过TensorRT 8,Hugging Face在BERT上实现了1毫秒的推理延迟,为助力实现大规模文本分析、神经搜索和对话式应用的AI服务提供加速度。

据悉,TensorRT目前还应用在了临床医疗领域,GE医疗就通过TensorRT来助力加速超声波计算机视觉应用,这是一款早期检测疾病的关键工具。TensorRT的实时推理能力提高了视图检测算法的性能,缩短了产品上市时间。实际工作中可让扫描仪在进行自动心脏视图检测时更高效,心脏视图识别算法会选择合适的图像来分析心壁运动。

TensorRT8无疑将让反应更快更聪明的客服机器人、实时翻译更迅速的应用变得可以翘首以待,也许能够随时接话茬的将不止是调皮的学生,机器人也可以做到。人与人之间的交流,语音上的牵绊变得更低,翻译可以同语音实时同步,即时记录成文字也不成问题,准确性也十分不错。更快更好的实时AI正在到来。

相关文章

- 英伟达Blackwell平台为AI推理工作负载带来全新水平的Token优化

- 三星HBM4高带宽内存正式进入英伟达Vera Rubin人工智能芯片平台

- 英伟达已瞄准台积电1.6nm产能,特斯拉/微美全息加速扩展AI芯片集群生态!

- 黄仁勋为何见她?英伟达中国行背后的工业AI落地逻辑

- 英伟达与OpenAI的千亿美元超级合作陷入停滞

- AMD与高通计划追随英伟达,下一代AI产品也将采用SOCAMM内存

- AI浪潮汹涌芯片突围战打响!英伟达/特斯拉/微美全息竞速引领基建突破新高度!

- 三星或将成为英伟达Vera Rubin平台首批HBM4内存供应商

- 英伟达CEO黄仁勋与AMD苏姿丰谈及当初选择台积电代工的决策如今收获丰硕

- 三星凭借与英伟达和苹果等巨头的长期合作,已在代工领域对英特尔形成压倒性优势

- 马斯克全力出击芯片制造,AI5芯片性价比远超英伟达Blackwell

- 国产存储突破:绿算GP7000率先适配英伟达G3层KV Cache架构,AI推理效率提升17倍

- 英伟达开源加速产业进程,均胜电子等相关Tier1迎来价值重估

- 英伟达AMD亮相CES 2026加速硬件进化 万兴科技引领应用层迭代

- 英伟达新一代Vera Rubin AI系统预计未来几年将消耗几百万TB的NAND闪存固态硬盘

- 英伟达CES预言自动驾驶未来,文远知行融合双技术路线领跑行业

人工智能企业

更多>>人工智能硬件

更多>>人工智能产业

更多>>人工智能技术

更多>>- 云知声Unisound U1-OCR大模型发布!首个工业级文档智能基础大模型,开启OCR 3.0时代

- 基石智算上线 MiniMax M2.5,超强编程与智能体工具调用能力

- 昇腾原生支持,科学多模态大模型Intern-S1-Pro正式发布并开源

- 百度千帆深度研究Agent登顶权威评测榜单DeepResearch Bench

- 在MoltBot/ClawdBot,火山方舟模型服务助力开发者畅享模型自由

- 教程 | OpenCode调用基石智算大模型,AI 编程效率翻倍

- 全国首个!上海上线规划资源AI大模型,商汤大装置让城市治理“更聪明”

- 昇思人工智能框架峰会 | 昇思MindSpore MoE模型性能优化方案,提升训练性能15%+