Adlik亮相国际电联峰会,推动AI触手可及

2021-11-03 10:13:50AI云资讯634

近日,由国际电信联盟(ITU)主办、中兴通讯联合鹏程实验室、Linux基金会等单位承办的AI for Good峰会第二场线上研讨会成功举办。本次研讨会的主题是“开源,加速人工智能技术创新”,国内外多位AI开源领域的专家和大家分享了各种由开源推动的AI最佳实践,包括来自Linux基金会人工智能和数据基金会(LF AI & Data)的执行董事Ibrahim Haddad、前TAC主席Jim Spohrer,以及来自OpenI、PaddlePaddle、柴火创客、OpenVINO、Milvus等多个AI开源社区的代表。中兴通讯高级开源工程师、Adlik开源项目的TSC主席袁丽雅发表了题为《Adlik,让人工智能触手可及》的演讲。

【Adlik背景】

Adlik是中兴通讯在LF AI & Data牵头发起的一项开源项目,旨在解决在深度学习模型落地过程中的挑战性问题,实现深度学习模型在特定硬件环境的部署、做到高效推理。袁丽雅提到,在这个过程中,模型训练只是第一步,如何根据应用场景确定硬件部署环境、如何确定各种不同环境下的模型部署和推理方案、如何完成复杂的调优工作以满足性能需求,每一个步骤对于模型的实际应用都至关重要。Adlik项目的诞生正是为了扫除这整个流程中的绊脚石。

Adlik作为一个深度学习推理工具链项目,可以为深度学习模型提供从训练完成,到部署到特定硬件并提供应用服务的端到端支持,其应用目的就是为了将模型从研发状态快速部署到生产应用环境。Adlik可以和多种推理引擎协作,支持多款硬件,提供统一对外推理接口,并提供多种灵活的部署方案,以及工程化的自适应参数优化方案,为用户提供快速、高性能的应用服务提供助力。

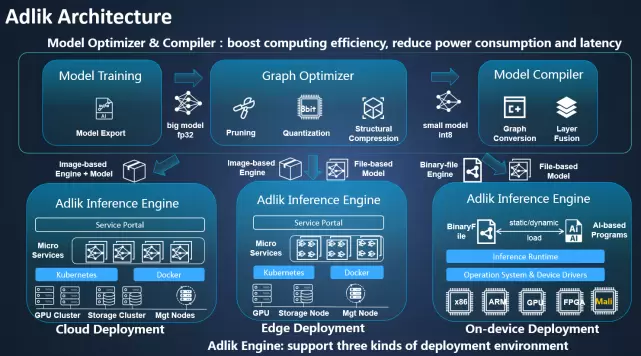

【Adlik架构】

Adlik在架构上,可以分为模型优化器模块(Optimizer),模型编译器模块(Compiler)和推理引擎模块(Inference Engine)。在模型训练完毕、应用场景确定之后,用户即可通过Adlik 模型优化器处理,生产优化后的模型,然后通过模型编译模块,完成模型格式转换,生成最终推理引擎支持的模型格式,最终完成在云边端等多种环境中的定制化部署,在最大化资源利用率的前提下,实现最佳的推理性能。

Adlik模型优化器支持剪枝、量化、知识蒸馏等多种模型优化、压缩技术,以ResNet-50为例,经优化器组合优化后,在模型的准确率基本不变的情况下,时延缩短为原来的1/4,计算量下降为原来的1/3,模型大小缩小为原来的1/12。

Adlik模型编译器通过DAG图的方式实现模型端到端的自动最优编译,另外通过常量折叠、层融合、步长优化等技术减少计算量、内存读写时间,进一步提升推理速度。在最新的版本中,Adlik基于升级优化的TVM自动搜索,能大幅加快调度参数的搜索过程。

Adlik推理引擎为深度学习或机器学习模型自动匹配加载插件式的推理运行时,实现模型的版本管理、运行调度,为人工智能应用提供满足性能要求的推理服务。在x86 cpu硬件执行DL模型推理的标准测试中,对标原始模型提升最大10倍的推理性能。

【Adlik展望】

Adlik项目目前已经发布了三个版本,已走进深水区,正在不断探索更加自动化的模型优化部署技术。比如说Adlik最近投入了对神经网络结构搜索的研究,近期将发布ZenNAS的加强版,基于原始阿里的ZenNAS框架做了一些优化,能大大加速网络搜索的过程。“这个工作将Adlik工作流的起点往前挪了一步,也使Adlik加速模型落地的步伐往前迈了一步”。袁丽雅表示。此外Adlik还会基于增强学习对模型编译器中算子的调度流程进一步优化,实现基于设备特性的最佳调度。

“更广泛的AI应用场景、更简单的操作、更优化的性能一直是Adlik技术演进过程中的原则”。 最后,袁丽雅描述了Adlik的终极目标:“让模型部署不再成为人工智能的应用瓶颈,让人工智能更触手可及。”