芯动力神速适配DeepSeek-R1大模型,AI芯片设计迈入“快车道”!

2025-02-07 16:36:39AI云资讯17970

近期,国产大模型 DeepSeek-R1横空出世,迅速成为AI领域的焦点。芯动力在24小时内完成了与DeepSeek-R1大模型的适配。

DeepSeek-R1是幻方量化旗下大模型公司DeepSeek研发的系列推理模型,自诞生起就备受瞩目。它采用强化学习训练,推理时包含大量反思和验证,思维链长度可达数万字。在数学、代码以及复杂逻辑推理任务上,DeepSeek-R1有着出色的表现,能取得媲美OpenAI o1的推理效果,还能为用户展现完整的思考过程 。在1月24日的Arena上,DeepSeek-R1 基准测试已经升至全类别大模型第三,其中在风格控制类模型(StyleCtrl)分类中与OpenAI o1并列第一。

随着技术的发展,大模型训练成本呈下降趋势,商业化门槛也随之降低。大模型作为技术底座,为各行业应用开拓了无限可能,这也让边缘大模型逐渐成为主流方向。而芯动力所设计的芯片恰好契合这一开发应用需求。

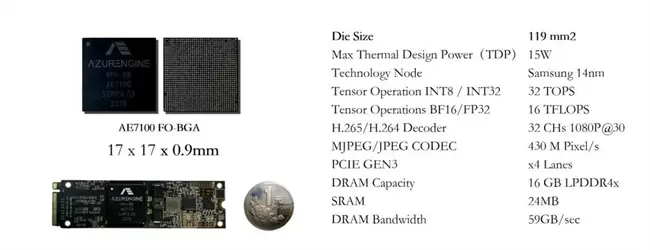

芯动力此次能够在如此短的时间内完成与DeepSeek-R1模型适配,AzureBlade K340L M.2加速卡是关键。这是一款高性能AI加速卡,实现了高性能、低功耗、小体积的完美结合。这款加速卡内嵌AE7100芯片,尺寸仅为22mm×80mm,大约半张名片大小,却实现了高达32TOPs的算力,并且功耗能达到8w以下。其采用标准M.2接口,便于集成到各种设备中,成为业界最小、最薄的GPU之一。该加速卡兼容CUDA和ONNX,满足各类AI应用需求,其高算力和内存带宽确保数据高效稳定处理与传输。目前,这款加速卡已经可以支撑大模型在AI PC等设备上运行,并适配了DeepSeek-R1、Llama 3-8B、Stable Diffusion、通义千问等开源模型。除此之外,该加速卡在工业自动化、泛安防、内容过滤、医疗影像及信号处理等领域也得到了广泛的应用。

AzureBlade K340L加速卡性能卓越、适用性广,有望在大模型端侧设备部署中发挥关键作用,助力 AI 技术在更多场景落地,推动 AI 技术发展与应用,开启 AI 应用新篇章。未来,芯动力团队还将在 AI 及其他行业持续创新突破,为生活和社会带来更多变革。

相关文章

- “工业版DeepSeek”,安世亚太精智 iGPT 工业大模型平台荣获国家工业大模型最高评级

- 媲美DeepSeek NSA!腾讯优图提出混合注意力机制SSA,长上下文外推更强

- 通用性再验证!DeepSeek-OCR 上线天数智芯与模力方舟合作平台

- 优刻得抢先接入DeepSeek-V3.2-Exp

- DeepSeek-V3.2-Exp 发布,训练推理提效,API 同步降价

- 基石智算上线 DeepSeek-V3.1-Terminus,更强 Agent 能力

- 青云AI算力云首登 AI Ping,刷新DeepSeek吞吐性能榜首

- 破解 AI “安全与性能” 难题!DeepSeek-R1-Safe 基础大模型在华为全联接大会2025正式发布

- 声网对话式AI引擎已接入DeepSeek-V3.1

- 腾讯云上线DeepSeek-V3.1 API,智能体开发平台和TI平台同步上线

- 特斯拉在中国市场放弃xAI的Grok大模型 选择接入DeepSeek AI技术

- DeepSeek-V3.1 发布,迈向 Agent 时代的第一步

- 如何查找全国新建工程项目信息?RCC瑞达恒接入DEEPSEEK,推出AI助手

- DeepSeek-R2要来了?速领450元代金券,模型测评快人一步!

- 禁令解除72小时:141GB H20 跑满血实测,DeepSeek 性能超预期

- 工学通与 DeepSeek:AI 领域的专业细分与通用探索