人工智能的“指数”增长正在改变计算的本质

2018-11-04 12:23:18AI云资讯1245

人工智能和机器学习的大规模应用正在改变计算的本质。

谷歌软件工程师Cliff Young于周四早上在Linley Group秋季处理器大会上发表了开幕主题演讲。

Young表示,人工智能的使用达到了一个“指数阶段”,同时摩尔定律,几十年前关于半导体进步的经验法则已陷入停滞状态。

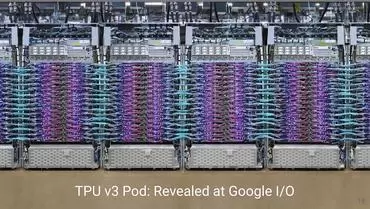

谷歌TPU阵列(图片来源:Google)

Young认为,由于传统芯片难以实现更高的性能和效率,因此AI研究人员的需求激增。

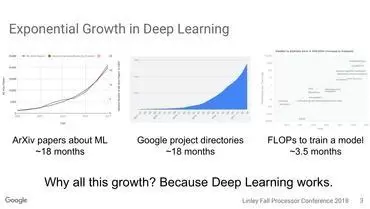

他发布了一些统计数据:康奈尔大学的关于机器学术论文数量每18个月增加一倍。

而在谷歌专注于人工智能的内部项目数量也每18个月增加一倍。

执行机器学习神经网络所需的浮点运算操作的数量每三个半月翻一番。

所有计算需求的增长都加起来就是“超级摩尔定律”。

传统的神经网络可能有数十万个这样的重量,必须计算,甚至数百万,谷歌的科学家们说“请给我们一台重量级的机器”,计算机能够计算万亿的重量。这是因为“每次你将神经网络的大小增加一倍,我们的准确度就会提高。” 。

机器学习增长趋势(图片来源:Google)

为了解决问题,谷歌一直在开发自己的机器学习芯片系列,即“Tensor Processing Unit”。需要TPU和类似的部件,因为传统的CPU和图形芯片(GPU)无法跟上。

TPU在2017年首次亮相时引起了骚动,其性能优于传统芯片。谷歌目前已进入TPU的第三次迭代,它在内部使用,并通过谷歌云提供按需计算节点。

此外:Google宣布推出Edge TPU,Cloud IoT Edge软件

该公司继续发展越来越大的TPU实例。Young表示,它的“pod”配置将1,024个单独的TPU连接到一台新的超级计算机上,而谷歌打算“继续扩展”该系统。

“我们正在构建这些巨大的多台计算机,具有数十亿的计算能力,”他说。“我们正在不断向前推进各个方向。”

TPU采用最快的内存芯片,即所谓的高带宽内存或HBM。他说,在训练神经网络时,对内存容量的需求急剧增加。

谷歌也正在调整它如何编程神经网络以充分利用硬件。“我们在数据和模型并行性方面做了大量工作”,其中包括“Mesh TensorFlow”等项目,这是对该公司TensorFlow编程框架的改编,该框架“将数据和模型并行化结合在一起”。

相关文章

- 智汇瓯江 智引未来:2025中国人工智能数字创新大会在温州成功举办

- 苹果人工智能服务器芯片Baltra或将用于执行人工智能推理任务

- 人工智能数据处理和质量测评中心全栈服务体系正式发布

- 中国开发区协会人工智能产业专业委员会在京成立

- 中国信通院政策与经济研究所李强治:我国人工智能治理迈入务实新阶段,场景与工具同步落地

- 中国信通院产业与规划研究所张桢:人工智能与城市全域数字化转型融合,正成为推动城市高质量发展的核心引擎

- 中国信通院产业与规划研究所徐志发:人工智能驱动数字消费深度变革,“十五五”时期将进入壮大发展的关键阶段

- 中国信通院云计算与大数据研究所栗蔚:智能算力重塑计算和网络架构,普惠化服务人工智能

- 中国信通院信息化与工业化融合研究所刘默:人工智能技术创新赋能制造业智能化迈入新阶段

- 中国信通院人工智能研究所魏凯:人工智能正从工具升级为伙伴,全面赋能高质量发展

- 中国心理科技园开园暨中国心理人工智能算力中心在京成立 心理产业迈入2.0时代:“心理AI产教融合生态”

- 蘑菇云荣膺教育强国论坛2025年度科技创新教育品牌 以创新产品赋能人工智能通识教育

- 英伟达在AI图形处理器上部署训练OpenAI的GPT-5.2,为人工智能产业提速

- 2025 全国人工智能应用场景创新挑战赛AI Agent全球专项赛线下半决赛新闻发布会在深圳召开

- 美图公司RoboNeo入选2025人工智能年度榜单

- 贵港移动公司共建人工智能联合实验室,推动产学研融合与产业数字化