腾讯朱雀实验室推出“隐形”水印 助力打击AI模型盗取行为

2021-11-13 22:30:31AI云资讯704

随着人工智能行业的发展,AI技术被大量应用到人们的生活中,而AI模型作为这些技术的载体,被广泛部署在云端。作为一种数字资产,AI模型面临着被窃取的风险,其安全性愈发引起业界关注。

11月11日至12日,全球知名信息安全峰会POC 2021正式举办,腾讯朱雀实验室高级研究员Mengyun Tang和研究员Tony受邀参加,并进行了题为《Towards AI Model Security Protection(AI模型的安全保护)》的分享。

在此次分享中,腾讯朱雀实验室展示了AI模型攻防实例,并提出了一种新的模型水印生成方法,这项技术可以防御多种模型窃取方式,并且对原模型的输出几乎不产生影响,为AI模型版权提供有效的保护。

AI模型维权,取证是难点

AI模型作为技术的核心载体,一旦被窃取,将可能使拥有该技术的企业或组织暴露在风险中。例如,某公司的AI模型被黑客恶意盗取后,黑客就可以复制该公司的业务,来抢占市场,获取间接经济利益,或者将模型出售给第三方,甚至勒索该公司,来获取直接经济利益。

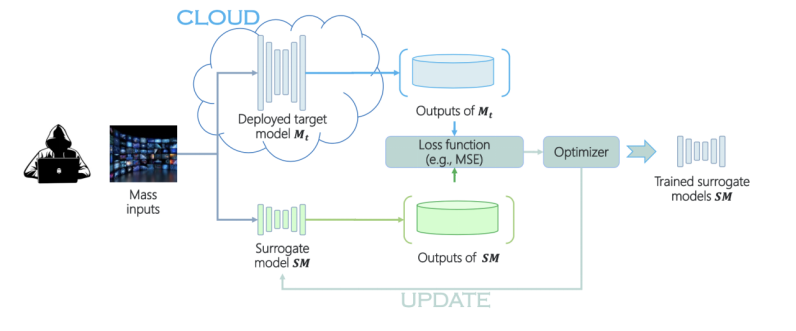

在模型窃取方式中,代理模型攻击是一种典型的手段,它通过训练与原模型功能相似的代理模型来蒸馏原模型的知识——将原模型的输入作为其输入,原模型的输出作为其训练标签,并进行参数优化,不断拟合原模型的输出,最终达到窃取原模型知识的目的。

模型窃取流程

而在面对模型窃取攻击时,模型的原作者往往容易处于被动。因为攻击者并不直接接触原模型,所以原作者无法提供直接证据,证明被窃取的模型中含有自己的知识产权,而陷入维权困难的境地。因此,一旦模型窃取攻击泛滥,将为人工智能的发展带来更多挑战。

“隐形”水印,AI模型版权保护新方法

针对上述问题,腾讯朱雀实验室结合最新的深度学习技术,推出了一套为AI模型提供保护的方法,即对疑似窃取模型进行“取证”,来证明该模型为“盗版”模型。

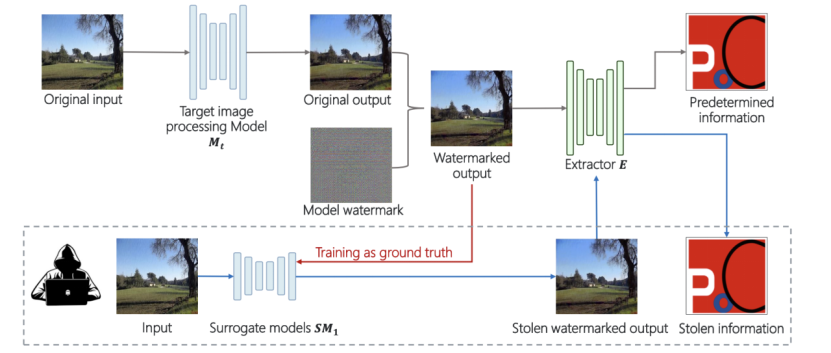

这套方法可以在预先防护阶段,生成肉眼不可见的水印,并将之添加到原模型的输出上,为原模型的输出“烙上”版权信息,同时,对原模型的输出几乎不产生影响。当AI模型被攻击时,其附带的水印也会被代理模型学习到,进而使得代理模型的输出中也含有该水印。

随后,通过经训练的提取器,可以从代理模型的输出中精准地检测到水印的存在,并将预先嵌入的模型版权信息进行高质量的还原,从而为模型原作者提供有力的技术证据,来对抗侵权行为。

朱雀实验室提出的模型水印生成方法及其保护流程

这项技术为AI模型提供了一道“胎记”,其意义在于,不仅能够有效地帮助AI模型作者维护自己的知识产权,还能打击“盗版”AI模型,一定程度地遏制模型窃取行为的发生,促进AI行业的生态持续健康发展。

腾讯安全平台部下属的腾讯朱雀实验室,致力于实战级APT攻击和AI安全研究,其建设的AI安全威胁风险矩阵,专门针对人工智能行业中的潜在风险提供研究和预案,为AI业务提供安全保障。

相关文章

- 罗技发布多款AI商用新品,携手微软、腾讯共探“智汇未来”新办公

- 品质出圈!可梦 AI《天阶玄猫之我在人间找妈妈》点亮腾讯视频 AI 动漫短剧赛道

- 腾讯安全闪耀2025东京游戏展,ACE和WeTest双线发力

- 中东AI迎来中国力量 华为腾讯云万兴科技等深度赋能区域数字化升级

- 腾讯云与 eMAG 达成战略合作 共推东欧电商数字化升级

- 腾讯的“鸿蒙速度”:60+应用已全面上架,携HarmonyOS 6首发多样创新体验

- PRCV2025大会顺利召开,腾讯优图携前沿科技成果亮相现场

- 连续入选!腾讯云列入Forrester终端管理平台全景报告代表厂商

- AI防护,与时俱进:信通院X电子科大X腾讯云共话大模型安全

- 腾讯云亮相GITEX GLOBAL 2025,携手阿联酋Tawasal升级超级应用体验

- 腾讯云全栈安全能力亮剑国家网安周,筑牢数字时代“智能防线”

- 腾讯PvEvP猎杀夺宝FPS新作,《灰境行者》全球首曝

- 腾讯《和平精英》官宣绿洲启元最高日活用户突破3300万

- 腾讯云TVP走进美的,共探智能制造新范式

- 共谈架构师 AI 进化论,腾讯云架构师技术沙龙圆满落幕

- 腾讯云与华东师范大学达成战略合作:攻坚国产数据库核心技术,加速AI落地