英特尔助力生成式AI,轻薄本运行大模型带来革新性PC体验

2023-08-25 10:24:15AI云资讯968

英特尔正在通过软件生态的构建和模型优化,进一步推动新兴的生成式AI场景在个人电脑的落地,通过Pytorch API让社区开源模型能够很好地运行在英特尔的客户端处理器、集成显卡、独立显卡和专用AI引擎上。

以第12代、第13代英特尔酷睿处理器和英特尔锐炫A系列显卡为代表的英特尔多款客户端芯片均能提供强劲性能,以满足生成式AI(AIGC)对于高算力的需求,在此基础上,英特尔还通过软件生态的构建和模型优化,进一步推动新兴的生成式AI场景在个人电脑的落地,广泛覆盖轻薄本、全能本、游戏本等。目前,英特尔正与PC产业众多合作伙伴通力合作,致力于让广大用户在日常生活和工作中,通过AI的辅助来提高效率,进而带来给革新性的PC体验。

英特尔积极拥抱AI社区,不久前宣布以Premier会员的身份加入PyTorch基金会。基于OpenVINO PyTorch后端的方案,通过Pytorch API让社区开源模型能够很好地运行在英特尔的客户端处理器、集成显卡、独立显卡和专用AI引擎上。以图形视觉领域为例, Stable Diffusion的实现Automatic1111 WebUI,已经能通过上述方式,在英特尔客户端平台的CPU和GPU(包括集成显卡和独立显卡)上运行FP16精度的模型,用户可以在文字生成图片、图片生成图片以及局部修复等功能上获得良好的使用体验。

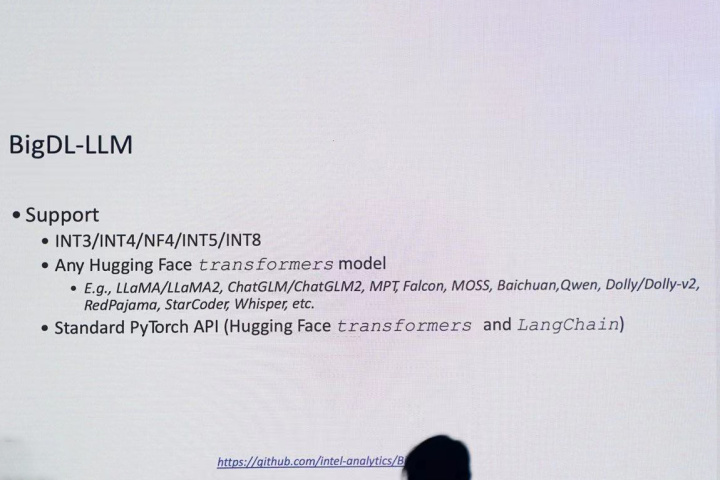

不仅如此,英特尔通过模型优化,降低了模型对硬件资源的需求,进而提升了模型的推理速度,让社区开源模型能够很好地运行在个人电脑上。以大语言模型为例,英特尔通过第13代英特尔酷睿处理器XPU的加速、low-bit量化以及其它软件层面的优化,让最高达160亿参数的大语言模型,通过BigDL-LLM框架运行在16GB及以上内存容量的个人电脑上。这也彰显了英特尔能够适应当下快速发展的大语言模型生态,快速对接新兴模型,并兼容目前HuggingFace上的Transformers模型。已经验证过的模型包括但不限于:LLAMA/LLAMA2、ChatGLM/ChatGLM2、MPT、Falcon、MOSS、Baichuan、QWen、Dolly、RedPajama、StarCoder、Whisper等。此外,英特尔还提供了易用的API接口(Transformers、LangChain),并支持Windows、Linux的操作系统。

英特尔的下一代处理器Meteor Lake具备独特的分离式模块架构的优势,为PC用户提供了以AI驱动的新功能,包括像Adobe Premiere Pro中的自动重新构图和场景编辑检测等多媒体功能,并实现更有效的机器学习加速。英特尔与PC产业合作伙伴此刻正站在旅程的起点,向着规模化应用AI加速转型的方向前行。随着英特尔后续几代产品进一步扩展,规模和数量的大幅增长将让数亿人轻松享受AI加速体验,并实现更优的智能协作、更快的处理速度和更强的功能特性实现前所未有的体验变革。

相关文章

- 英特尔称服务器CPU将重新火热:AI工作负载推动增长

- 英特尔复苏进行中,代工业务成为关注焦点

- 英特尔发布2025年第三季度财报

- 剪映联合英特尔、中国传媒大学举办“即梦AI放映厅”等系列活动

- 英特尔锐炫多卡方案:从边缘到数据中心,为全场景AI部署提供高效部署路径

- 终端 AI 奇点已至,英特尔点燃 PC 新范式

- 从技术到生态:英特尔与中国移动咪咕合作升维,聚力共赢超级体育赛历

- 英特尔与中国移动咪咕启动2025-2026年战略合作,共迎“超级体育年”

- 共绘工业智能新未来:英特尔全栈AI与生态成果闪耀第二十五届工博会

- PICO × 英特尔× 央美共探 AI 艺术新生态:技术重塑创作、教育与产业未来

- 英特尔助力阿里云推出多款云实例与存储方案,共筑AI时代云端算力基石

- 英特尔携手生态合作伙伴集结工博会,共塑具身智能新图景

- 英特尔通感智算深度融合,赋能云边端智能未来

- 拥抱AI PC:英特尔联手微软、京东,以智能科技点亮校园生活

- 英伟达斥资50亿美元入股英特尔 合作开发个人电脑和数据中心芯片

- 英特尔中国区董事长王锐将于本月荣休