英伟达Rubin平台采用HBM4内存实现50 PetaFLOPs算力,搭载88核Olympus架构Vera CPU,相较Blackwell性能提升5倍

2026-01-06 08:32:00AI云资讯2563

(AI云资讯消息)英伟达今日正式发布Rubin人工智能平台,该平台将成为下一代数据中心的核心架构,性能较Blackwell提升5倍。此前业界普遍预期英伟达将在GTC大会上发布相关更新。鉴于人工智能领域的蓬勃发展与CES展会期间全行业对AI技术的高度聚焦,英伟达决定将其重磅AI平台的亮相时间稍作提前。

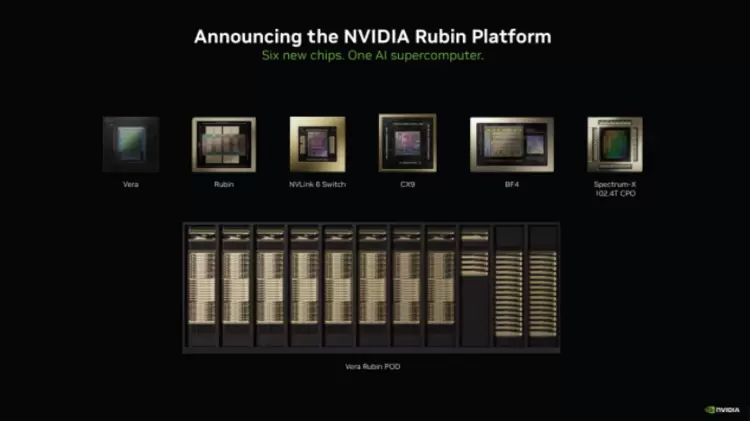

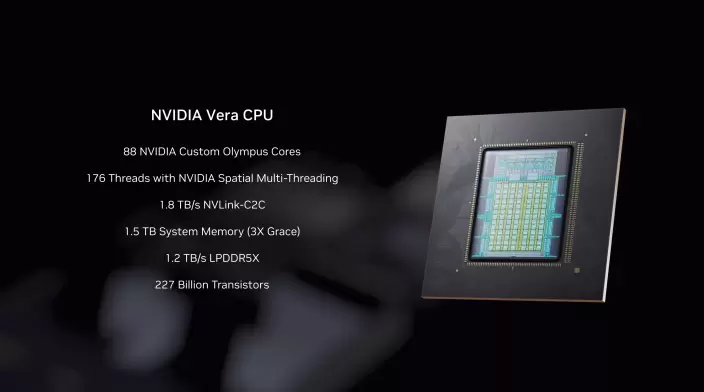

英伟达Rubin平台将由六颗芯片构成,目前所有芯片已完成晶圆厂生产并运抵英伟达实验室进行测试。这些芯片包括:Rubin GPU(集成3360亿晶体管)、Vera CPU(集成2270亿晶体管)、用于互连的第六代NVLink交换机、用于网络连接的CX9网卡与BF4 DPU、用于硅光互联的Spectrum-X 102.4T共封装光学模块。

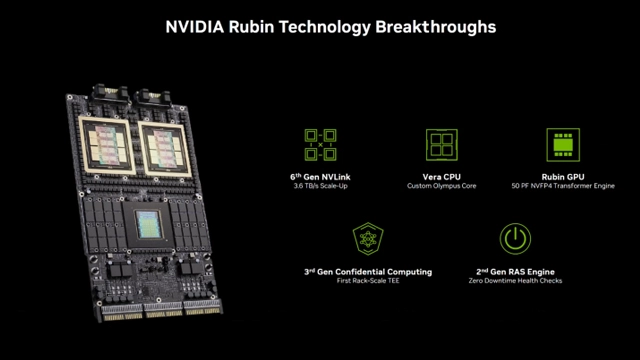

这些芯片组合将使Rubin平台在DGX、HGX和MGX系列系统中全面运行。每个数据中心的核心将是英伟达Vera Rubin超级芯片,其配备两颗Rubin GPU、一颗Vera CPU,并采用HBM4和LPDDR5x配置提供海量内存。英伟达Rubin技术的核心亮点包括:第六代NVLink(3.6 TB/s纵向扩展带宽)、Vera CPU(定制化Olympus核心架构)、Rubin GPU(50 PetaFLOPS NVFP4 Transformer引擎)、第三代机密计算(首个机架级可信执行环境)、第二代RAS引擎(支持零停机健康检测)。

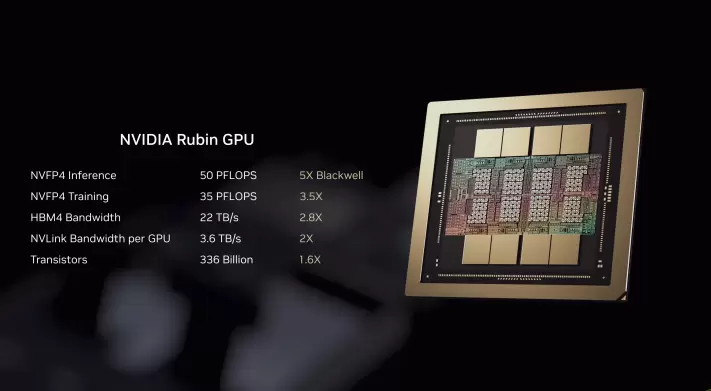

首先来看Rubin GPU,这款芯片采用双光罩模片设计,每个模片都集成了大量计算核心与张量核心。该芯片专为AI密集型工作负载打造,可提供50 PetaFLOPS的NVFP4推理算力与35 PetaFLOPS的NVFP4训练性能,分别达到Blackwell芯片的5倍和3.5倍。芯片同时搭载HBM4内存,每芯片内存带宽最高达22 TB/s,较Blackwell提升2.8倍;CPU侧NVLink带宽为3.6 TB/s,实现2倍于Blackwell的传输速率。

针对Vera CPU,英伟达研发了新一代定制化Arm架构(代号Olympus)。该芯片集成88个核心、176线程(支持英伟达空间多线程技术),配备1.8 TB/s NVLink-C2C一致性内存互联通道,支持1.5 TB系统内存(为Grace平台的3倍),通过SOCAMM LPDDR5X实现1.2 TB/s内存带宽,并具备机架级机密计算能力。这些特性共同带来相较于Grace平台2倍的数据处理、压缩及CI/CD性能提升。

第六代NVLink交换机为Rubin平台提供网络架构,采用400G SerDes技术,每CPU支持3.6 TB/s全对全带宽,总带宽达28.8 TB/s,支持14.4 TFLOPS FP8网络内计算,并采用100%液冷设计方案。

网络连接由最新ConnectX-9与BlueField-4模块驱动。ConnectX-9超级网卡提供1.6 TB/s带宽,采用200G PAM4 SerDes技术,配备可编程RDMA与数据路径加速器,具备顶级安全性,并为超大规模AI集群进行深度优化。

BlueField-4是一款面向智能网卡与存储处理器的800G DPU。该芯片集成64核Grace CPU与ConnectX-9网络模块,相比BlueField-3实现2倍网络传输能力、6倍计算性能与3倍内存带宽提升。

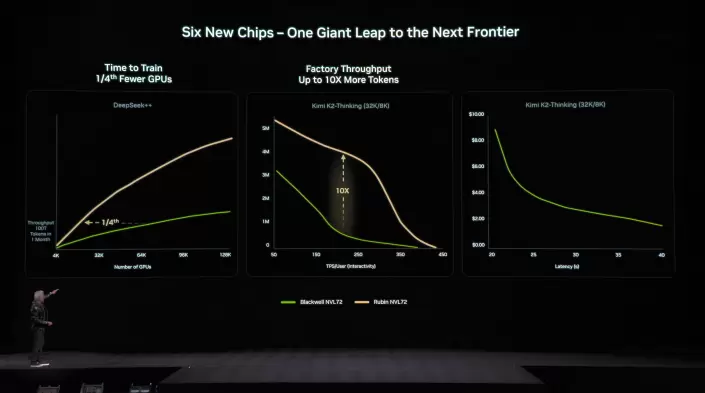

所有这些技术最终汇聚于英伟达Vera Rubin NVL72机架系统,相较Blackwell平台实现显著性能跃升,具体数据如下:NVFP4推理性能提升5倍(达3.6 EFLOPS)、NVFP4训练性能提升3.5倍(达2.5 EFLOPS)、LPDDR5x内存容量提升2.5倍(达54 TB)、HBM4显存容量提升1.5倍(达20.7 TB)、HBM4显存带宽提升2.8倍(达1.6 PB/s)、纵向扩展带宽提升2倍(达260 TB/s)。

英伟达同时发布Spectrum-X以太网共封装光学解决方案,提供102.4 Tb/s横向扩展交换架构,集成200G硅光共封装技术,在大规模部署中可实现95%的有效带宽利用率。该系统能效提升5倍,可靠性增强10倍,应用程序运行效率提高5倍。

针对Rubin SuperPOD系统,英伟达同时推出推理上下文内存存储平台。该平台专为千亿级参数推理场景构建,并与英伟达Dynamo、NIXL及DOCA等软件解决方案实现全面集成。

总而言之,英伟达将在其顶尖的DGX SuperPOD中部署Rubin平台,采用8组Vera Rubin NVL72机架。此外,针对主流数据中心市场,英伟达还将推出NVIDIA DGX Rubin NVL8配置方案。

凭借这些技术进步,相比Blackwell GB200平台,英伟达Rubin平台将推理token成本降低10倍,训练MoE模型所需GPU数量减少4倍。Rubin生态系统已获得众多合作伙伴支持并实现全面量产,首批芯片将于今年晚些时候交付客户。

相关文章

- 三星HBM4高带宽内存正式进入英伟达Vera Rubin人工智能芯片平台

- 英伟达已瞄准台积电1.6nm产能,特斯拉/微美全息加速扩展AI芯片集群生态!

- 黄仁勋为何见她?英伟达中国行背后的工业AI落地逻辑

- 英伟达与OpenAI的千亿美元超级合作陷入停滞

- AMD与高通计划追随英伟达,下一代AI产品也将采用SOCAMM内存

- AI浪潮汹涌芯片突围战打响!英伟达/特斯拉/微美全息竞速引领基建突破新高度!

- 三星或将成为英伟达Vera Rubin平台首批HBM4内存供应商

- 英伟达CEO黄仁勋与AMD苏姿丰谈及当初选择台积电代工的决策如今收获丰硕

- 三星凭借与英伟达和苹果等巨头的长期合作,已在代工领域对英特尔形成压倒性优势

- 马斯克全力出击芯片制造,AI5芯片性价比远超英伟达Blackwell

- 国产存储突破:绿算GP7000率先适配英伟达G3层KV Cache架构,AI推理效率提升17倍

- 英伟达开源加速产业进程,均胜电子等相关Tier1迎来价值重估

- 英伟达AMD亮相CES 2026加速硬件进化 万兴科技引领应用层迭代

- 英伟达新一代Vera Rubin AI系统预计未来几年将消耗几百万TB的NAND闪存固态硬盘

- 英伟达CES预言自动驾驶未来,文远知行融合双技术路线领跑行业

- 苹果或将与英伟达在台积电争夺相同的3D封装产能资源