算力靠“连”不靠“堆”!选对机头CPU才能引爆AI服务器潜能

2026-02-05 12:26:55AI云资讯1307

如果要用两个字来形容当下AI技术热潮,在模型或AI应用层面无疑就是一个“大”字,它背后是越来越复杂的模型架构,以及动辄百亿千亿的参数规模;硬件或算力层面则是个“多”字,直指AI算力基础设施对GPU或AI加速器“多多”益善的追求,这也是全球顶尖AI玩家们大搞GPU“军备竞赛”或“囤卡备战”的底层逻辑,即手里卡够,心里不慌。

卡堆够了,算力就能随叫随到了么?No,这只是万里长征第一步,下一步考验的是连卡,也就是在小到单个AI服务器节点,大到千卡万卡级的集群中,如何才能让堆上去的多块GPU或AI加速器实现最大化互连与通信效率,这才是它们高效协作输出充沛算力,不浪费每一分投资的关键。

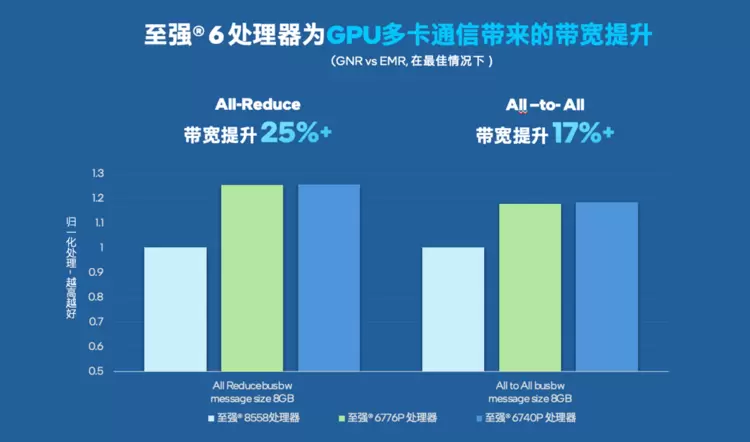

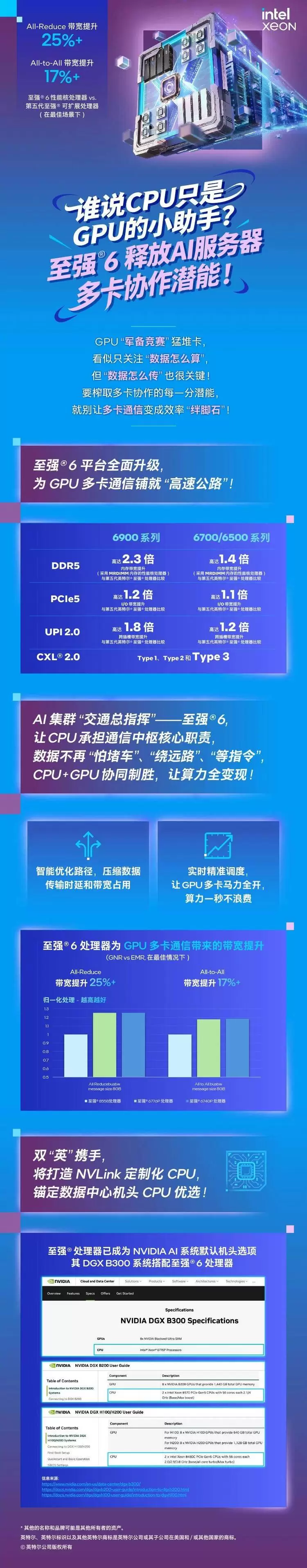

在连卡的过程中,机头或主控CPU的作用是不可忽视的,选对产品与型号带来的收益也超乎想象,以英特尔最新公布的一组数据为例,选择至强6性能核处理器作为机头CPU,在最佳场景下,其NCCL All-Reduce带宽相较第五代至强可扩展处理器可提升达25%以上,All-to-All带宽提升也有17%以上。

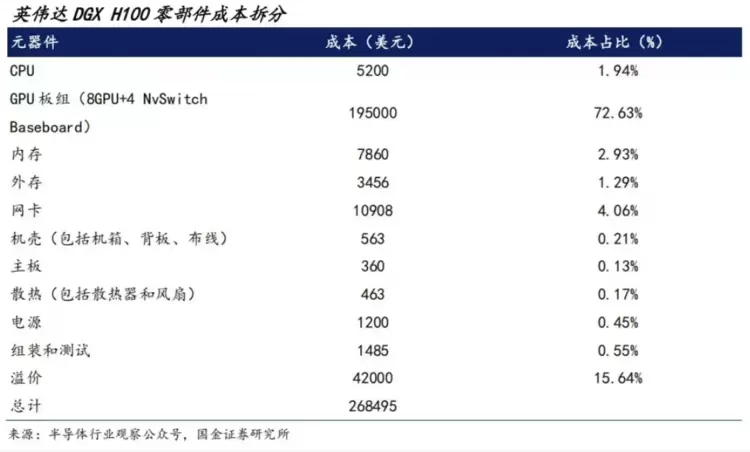

有趣的是,换来这些提升的成本,对整个AI服务器或集群的采购或总拥有成本来说,都是九牛一毛——援引国金证券研究所对英伟达DGXH100零部件成本的拆分,机头CPU成本占比只有1.94%。即便把成本拆分的目标换成定位中低端的AI服务器,GPU或AI加速器也依然是大头所在。相比之下,机头CPU虽然在投入上微不足道,却能扮演撬动整个系统或集群效率的“杠杆”,它能撬开、释放GPU和整个AI服务器的全部潜能,这才是真正意义上的花“小钱”、办“大事”。

多卡通信,何以“至强”?

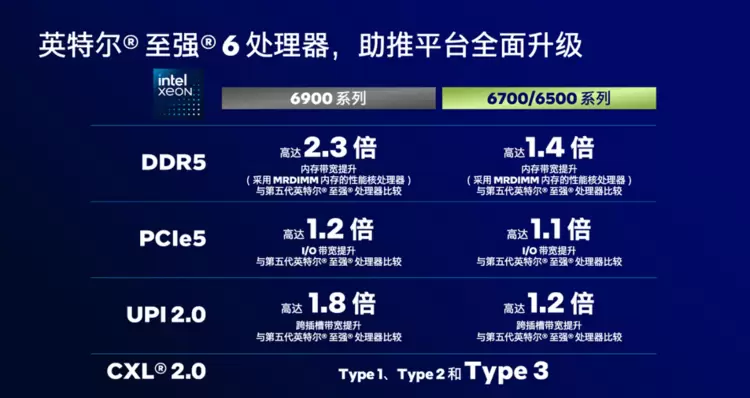

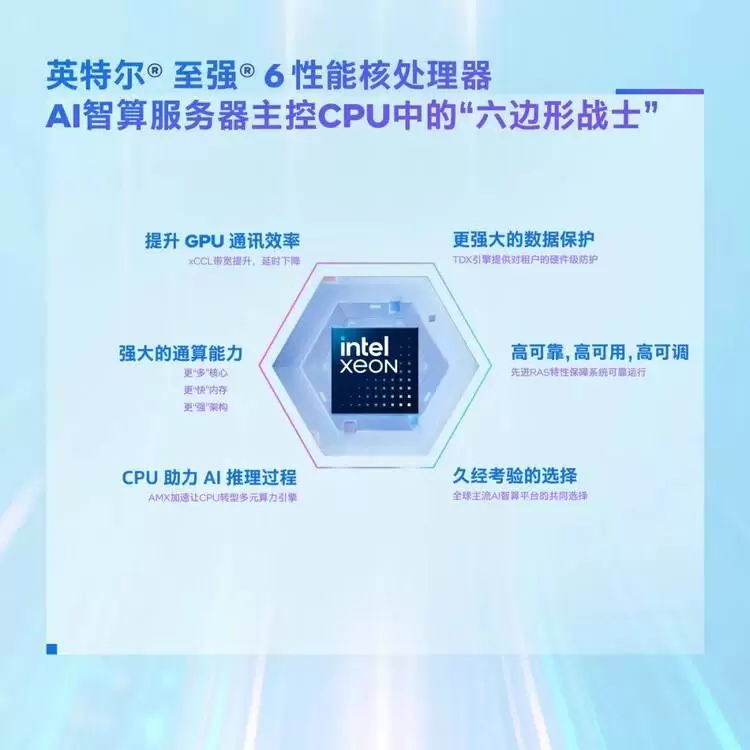

收益看到了,要付出什么也很清晰,也许你想进一步深究至强6提升多卡互连与通信效率的秘籍,那下面这一张图就足以揭示它的底气所在。

这张图上涉及的几乎所有硬件规格与性能提升,不论是直接服务于GPU/AI服务器的PCIe,还是作为整个系统数据交换池的内存子系统,又或是CPU间互连的UPI,其最终目标都可作用于多卡通信这一核心场景,即为GPU之间的数据交换铺设更宽、更快的“高速公路”,其最直观的体现就是多卡互连通信带宽及时延压缩的显著改善。

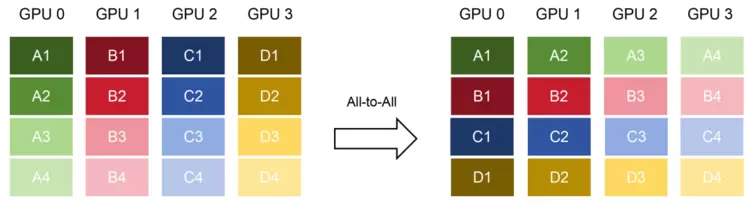

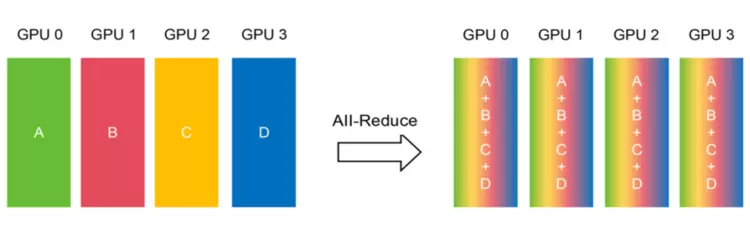

这种改善有何实际意义?以AI模型的分布式训练场景为例:各个GPU节点需要频繁地同步梯度参数(All-Reduce过程),这正是最考验通信效率的环节,而在样本分片重分配等场景中,All-to-All 过程同样对通信链路有着强需求。如果机头CPU能提供更高的聚合带宽,能让数据汇总和分发的速度更快,就可缩短训练的单步迭代时间,加速整个训练进程。

再以应用更广泛、也标志着AI真正投入实战的推理场景,如目前越来越火的多模态大模型推理为例,虽然它不需要做梯度同步,但All-Reduce性能提升仍可能作用于多节点推理的协调或一致性生成中的多GPU同步;All-to-All性能提升在推理中更加关键,其生成速度(或等待时间)、服务吞吐(单位时间能否服务更多客户)、应用规模(能否支持更多模型或更长序列)等关键指标,都可借势得到进一步优化。

行业背书:机头CPU的“默认选项”

通过上面的例子,我们能清晰感受到:GPU就像高精尖的“算力工厂”,产能惊人。但如果连接这些工厂的道路网络(数据链路)频繁“堵车”,信息流转不畅,那么再强的生产力也无法有效协同,最终导致昂贵的GPU资源在等待中被空耗。在这个背景下,如何高效疏导数据流,保障多卡通信的畅通无阻,变得比以往任何时候都更加重要。说白了,算力再强也怕堵!

因此在日趋庞大和复杂的AI集群中,就需要一个“交通总指挥”来统一调度数据、分派任务。这个角色,正是由机头CPU来担当。多年以来,英特尔® 至强® 处理器凭借其强劲可靠的通用计算能力、出色的稳定性和广泛的生态兼容性,一直是业界公认的机头CPU默认选项。

这种行业共识并非空穴来风。来看看行业风向标——英伟达的动作吧,它早就在其官方解决方案中将至强处理器作为官方认证和推荐的机头CPU选择。2025年双“英”还进一步升级了双方的合作关系,其中关键一条就是英特尔将利用NVLink设计和制造定制化的数据中心CPU,其用途不言而喻。

需要说明的是,这种共识的背后,可不仅是行业对至强处理器在多卡互连与通信这一单项能力的认可。也许对于其他CPU产品来说,其计算、通信与存储的性能可支持GPU高效顺畅的工作,就已是接近“满分线”的表现,但对至强来说这些只是作为机头CPU的“基线”而已,在这条线之上,它还能用内置AMX技术帮GPU分担AI数据预处理,特别是向量数据库的加速;能借助CPU更大容量的内存从GPU上卸载MoE,特别是冷专家,以释放GPU显存来提升并发度和拓展上下文窗口;能用六大类52项RAS功能来保障AI服务器或集群的高可靠、高可用和高可维护,助力用户实现99.999%的可靠性;能借助TDX技术构建硬件级“可信AI”执行域,甚至CPU与GPU之间都会构建加密专线来强化AI模型与数据的保护……这些,才是它的独有的加分项,才是它能脱颖而出,成为行业默认机头CPU靠谱之选的竞争力。

©英特尔公司,英特尔、英特尔 logo 及其它英特尔标识,是英特尔公司或其分支机构的商标。

*文中涉及的其它名称及品牌属于各自所有者资产。

相关文章

- 算力靠“连”不靠“堆”!选对机头CPU才能引爆AI服务器潜能

- I/O完成关键突破,我国算力核心部件攻克国产化“最后1%”

- I/O完成关键突破 我国算力核心部件攻克国产化“最后1%”

- 青云科技清微智能:面向未来的国产 AI 算力“强耦合”

- 让AI算力触手可及,《1ms城市算网创新应用汇编(2025年)》正式发布

- 董恒江出席并发布《中国文化出海算力需求研究报告》

- 共绩算力:春节流量洪峰将至,你的AI应用“扛得住”吗?

- 云工场科技中标逾5亿元算力项目,推动国产AI算力集群规模化建设

- AI算力散热新纪元:瑞为新材以金刚石散热引领芯片热管理革命

- 博大数据入选“绿色低碳先进企业”,以技术创新引领算力基础设施绿色升级

- 算力需求激增引风口 寒武纪技术迭代赋能智能化升级

- 协创数据2025年业绩预增超50%:存储算力双轮驱动 构筑AI基建核心竞争力

- 彤央边端产品发布|100-300TOPS 稠密算力落地,云边端算力版图成型

- 维谛技术(Vertiv)37个集装箱集结完毕:汽车行业的算力引擎,由此启动

- 维谛技术Sidecar液冷:以高效“旁挂”哲学,破解AI算力高密散热挑战

- AI游刃有余 | 浪潮云海InCloud AIOS:异构算力“小时级”适配 打通智能生产力最后一公里

人工智能企业

更多>>人工智能硬件

更多>>人工智能产业

更多>>人工智能技术

更多>>- 百度千帆深度研究Agent登顶权威评测榜单DeepResearch Bench

- 在MoltBot/ClawdBot,火山方舟模型服务助力开发者畅享模型自由

- 教程 | OpenCode调用基石智算大模型,AI 编程效率翻倍

- 全国首个!上海上线规划资源AI大模型,商汤大装置让城市治理“更聪明”

- 昇思人工智能框架峰会 | 昇思MindSpore MoE模型性能优化方案,提升训练性能15%+

- 媲美DeepSeek NSA!腾讯优图提出混合注意力机制SSA,长上下文外推更强

- SOTA达成!腾讯优图D-Search算法登顶国际AI权威榜单

- 智象未来团队荣获ACM Multimedia 2025最佳演示奖,多模态生成式AI技术领跑全球