麻省理工学院林肯实验室开发人工智能展示其决策过程

2018-12-28 11:08:17AI云资讯1438

在麻省理工学院林肯实验室智能与决策技术小组发表的一篇论文中(“设计的透明度:弥合视觉推理中的性能与可解释性之间的差距”)今年夏天在计算机视觉和模式识别会议(CVPR)上发表,研究人员描述了执行“人类”推理以回答有关世界的问题的系统-即图像的内容。

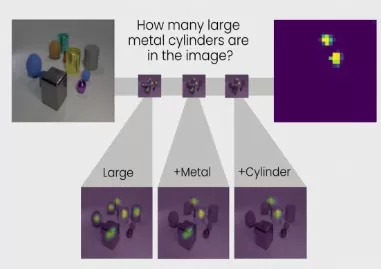

神经网络-被称为透明度设计网络(TbD-net)-用热图描绘其视觉分析。在对照片进行解读时,它会以明亮,易于识别的颜色(用于研究人员的说法中的“注意力掩模”)突出显示感兴趣的项目,这些颜色代表模块的输出,或专门用于执行特定任务的小型神经网络。

麻省理工学院新闻报道称,“就像工人下线一样,每个模块都会在模块出现之前建立最终产生最终正确答案的模块。”“作为一个整体,TbD-net利用一种AI技术来解释人类语言问题并将这些句子分解为子任务,然后是多种计算机视觉AI技术来解释图像。”

那么它怎么能回答像“大金属立方体是什么颜色”这样的问题呢?首先,模块会隔离大对象。然后第二个模块将识别哪些对象是金属。第三个将查找符合先前标准的立方体,最后,第四个将确定对象的颜色。

在涉及85,000个训练图像和850,000个问题的测试中,TbD-net的准确度为98.7%,优于其他基于神经模块网络的方法。更重要的是,它实现了最先进的性能-99.1%的准确度-部分归功于它产生的热图插图,这使得研究人员可以非常精确地调整它以进行后续测试。

这篇论文的作者认为,对神经网络推理的这种洞察力可能对建立用户信任大有帮助。

最近几个月,许多公司,政府机构和独立研究人员试图解决人工智能中所谓的“黑匣子”问题-一些人工智能系统的不透明性-并取得了不同程度的成功。

2017年,美国国防高级研究计划局启动了DARPAXAI计划,旨在生产“玻璃盒”模型,在不牺牲性能的情况下轻松理解。今年8月,IBM的科学家们提出了一份人工智能的“情况说明书”,它将提供有关模型漏洞,偏见,对抗性攻击易感性和其他特征的信息。微软,IBM,埃森哲和Facebook开发了自动化工具来检测和减轻AI算法中的偏差。

“人工智能系统具有改变我们生活和工作方式的巨大潜力......[但]这些[透明度]问题必须得到解决才能让人工智能服务得到信任,”IBM研究院和联合会的AI基金会负责人AleksandraMojsilovic说道。8月份接受VentureBeat采访时,人工智能科学促进社会福利计划。

相关文章

- Anyty(艾尼提)产品赋能文博考古“现场移动实验室”建设

- 香港科技大学与英特尔共建联合实验室,聚焦高能效智能计算

- 守护全景场健康,圣奥实验室扩项获CNAS评审认可,再添品质硬核防线

- 从尾货处理到新品试销,好特卖如何成为品牌的零售实验室?

- 亚信科技、ABB机器人联合成立“具身智能实验室”共筑Physical AI新范式

- 勤哲Excel服务器:让实验室数据采集与报表生成高效可控

- 让大模型“长出”手脚:云从科技联手嘉陵江实验室 加速人工智能走向物理世界

- 技术赋能,战略升维:天立教育与北航国际创新研究院共建教育AGI联合实验室

- 腾讯视频与北京电影学院达成战略合作 共建“AI影视联合实验室”

- 黑芝麻智能与联想研究院机器人实验室达成战略合作,共推机器人产业创新与落地

- 云迹科技携手顶尖机构共建北京市重点实验室,抢占具身智能万亿赛道制高点

- 支持影视工业化产研协同,爱奇艺联合北京电影学院成功申报北京市重点实验室

- 聚力自主可控AI算力,天数智芯-湘江实验室联合研究院揭牌

- 卓翼飞思实验室赋能首届具身智能系统及应用大会暨无人系统具身智能算法挑战赛

- 贵港移动公司共建人工智能联合实验室,推动产学研融合与产业数字化

- 十年追光路,把脑机接口从实验室带到现实