浪潮AI服务器大幅提升NLP模型Transformer训练性能

2019-09-12 17:05:14AI云资讯748

近日,在北京举行的2019人工智能计算大会(AICC 2019)上,浪潮发布主流自然语言处理(NLP)模型Transformer的最新性能测试数据。Transformer模型参数规模可达数亿,对计算、通信的要求非常高。性能数据显示,相比同类服务器,浪潮AI服务器NF5488M5大幅提升了Transformer的训练性能,GLUE基准训练至80.4%的时间相比同类产品大幅减少67%。

浪潮AI服务器NF5488M5

人工智能正在由“能看、会听”的感知智能向“能读、会写”的认知智能迈进。由于文字是信息、思想的重要载体,如果计算机能够理解文字并能够用文字表达,那么就具备了读写能力,因而NLP被认为是认知智能的重要突破口。目前主流的NLP模型包括Transformer, Bert, GPT, XLNet等,而Bert和GPT都基于Transformer架构。Transformer被视为是NLP的经典模型,2017年由谷歌提出,其利用自注意力(self-attention)机制实现快速并行,并且可以增加到非常深的深度,充分发掘DNN模型的特性,提升模型准确率。

但是Transformer模型训练是一大难题,因为其参数规模达到数亿,对计算力的需求很大。OpenAI的Transformer模型有12层、768个隐藏单元,使用8块P100 GPU在8亿词量的数据集上训练40个Epoch需要一个月。背后的原因很大程度上在于GPU通信制约。Transformer Attention机制的全连接层计算时会产生海量参数,而更新参数梯度需要GPU间高速传输。同时,模型规模很大导致占用大量GPU显存,而batchsize通常都很小,导致每次计算的时间较快,计算后更新参数梯度频繁,这也进一步要求更高的GPU间传输速度。

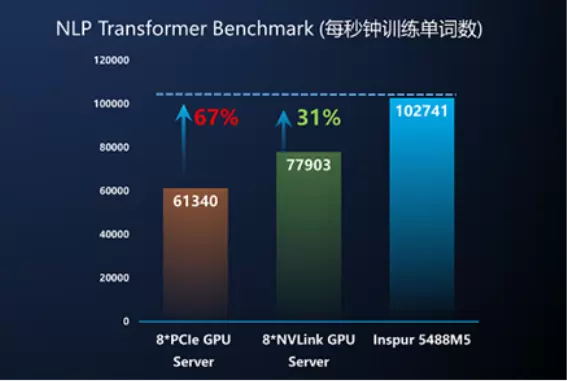

浪潮AI服务器NF5488M5 通过无阻塞的GPU全互连设计,突破性地实现了All to All 300GB/s的Peer to Peer带宽。在当前深度学习通信模型All Reduce性能表现上,NF5488M5的实际通信带宽可以达到采用常规NVLink互联的GPU服务器的3倍以上。正是这种特性,大大提升了Transformer模型在NF5488M5上的通信效率,从而加大了计算通信比,节约了整体运行时间。测试结果表明,NF5488M5大幅提升了Transformer训练性能,GLUE基准训练至80.4%的时间比采用PCIe互联的8GPU服务器缩短67%,比采用常规NVLink互联的8GPU服务器缩短31%。

Transformer训练性能测试结果

浪潮集团AI&HPC总经理刘军认为,当前基于Transformer的Bert, XLNet等模型代表了NLP的发展方向,而它们的特点就是加速器间通信制约。测试结果充分表明浪潮AI服务器NF5488M5在GPU间通信效率上具有显著领先优势,能够大幅提升Transformer等大型AI工作负载的训练性能,降低训练成本,加速认知智能研发和应用落地。

浪潮是人工智能计算的领导品牌,AI服务器中国市场份额保持50%以上,并与人工智能领先科技公司保持在系统与应用方面的深入紧密合作,帮助AI客户在语音、语义、图像、视频、搜索、网络等方面取得数量级的应用性能提升。浪潮与合作伙伴共建元脑生态,共享AI计算、资源与算法三大核心平台能力,助力行业用户开发并部署属于自己的“行业大脑”,加速推进产业AI化落地。

相关文章

- 指尖上的全球贸易:宜选网引领跨境B2B移动化浪潮

- 首部轻量云研究报告重磅发布 浪潮云海可演进架构护航企业平滑升级

- 从桌面到指尖:宜选网引领B2B贸易移动化浪潮

- 浪潮数据×南京极域打造新一代云智融合智慧教室

- AI游刃有余 | 告别繁琐点选,浪潮云海AI助手开启对话式运维时代

- 穿越浪潮 · 自成航线丨SEVENS赛文思2025年度报告

- 回望2025:AI浪潮下律师的坚守与蜕变 百度法律智能体年终直播预告

- 中国信通院牵头多项数据库标准正式实施,浪潮KaiwuDB深度参与

- 智驾普及浪潮下的资本选择:元戎启行20万辆交付引产业资源加速聚拢

- 2025浪潮计算机智慧算力创新发展论坛圆满举办

- 浪潮云海亮相第七届浙江国际智慧交通产业博览会 云边端协同筑牢智慧高速转型底座

- 上海疾控携手浪潮云海入选中国信通院2025“一云多芯”创新应用实践

- 浪潮KaiwuDB x智信能科:多模数据库支撑新能源电力预测系统创新实践

- 浪潮云海AI云基础设施平台InCloud AIOS入选中国信通院AI Cloud典型案例

- 赛业生物AI抗体技术入选工信部首批典型案例,引领生物制造创新浪潮

- 浪潮通信信息参编《低空智能网联体系发展路径及趋势》报告发布