在这里看懂算法!Google新AI工具解码神秘算法原理及过程

2019-11-25 16:05:02AI云资讯753

虽然大多数人每天都会遇到算法,但没有多少人可以说他们真的了解AI的实际工作原理。但是,Google推出了一种新工具,希望能够帮助普通人掌握机器学习的复杂性。

该工具被称为“可解释AI”(Explainable AI),它可以向用户解释机器学习模型的处理结果是如何得出以及为什么得出决策的。

谷歌表示,这样做将用户更加信任机器学习模型。这一点很重要,之所以大多数现有模型往往相当不透明,是因为多数用户不清楚他们如何做出决定。

可解释AI给算法打分、量化数据因素,让你更懂算法

为此,可解释AI工具将量化数据集中每个特征对算法结果的贡献,每个数据因子都会有一个分数,来反映了它对机器学习模型的影响程度。

用户可以拉出该分数,来了解给定算法为何做出特定决策。例如,对于决定是否批准某人贷款的算法模型,“可解释AI”将显示帐户余额和信用评分作为最决定性决策的依据数据。

谷歌云首席执行官托马斯·库里安(Thomas Kurian)在伦敦的Google活动中介绍了该新功能,他说:“如果您使用AI进行信用评分,您会想知道为什么算法模型根据信用评分通过这个人却拒绝了另外一个。”

他说:“对于在企业的业务流程中使用人工智能的客户,‘解释AI’可以帮助您理解为什么人工智能基础架构能够产生特定的结果。”换句话说,“可解释AI”能否准确解释特定机器学习模型为何得出结论,对于企业中负责最终决策的高管来说很重要。对于高度严格的行业来说,能够相信AI作出的决策是至关重要的。

“可解释AI”现在可以用于托管在Google的AutoML Tables 和Cloud AI Platform Prediction上的机器学习模型。

此前,谷歌也曾采取措施使算法更加透明。去年,它推出了“假设工具”,供开发人员在使用谷歌的AI平台时,能够可视化和探查数据集。

通过量化数据因素,“可解释AI”可以给出更多见解,并让更多用户读懂这些见解。

“模型卡”将算法“黑匣子”打开,提供有关特定算法详细实用信息

Google Cloud战略主管Tracy Frey说:“您可以将‘可解释AI’与我们的假设分析工具配合使用,以全面了解算法模型的行为。”

在某些领域,例如医疗保健,提高AI的透明度将特别有用。例如,在某些疾病诊断的算法中,它会将医生诊断病症并给出决策的过程可视化,并验证这些症状不是假阳性或其他疾病的征兆。

谷歌还宣布将推出所谓的“模型卡”的新概念,即提供有关特定算法快速信息的简短文档。

这些文档实质上是用于机器学习的ID卡,其中包括有关模型性能和限制的详细实用信息。谷歌表示,这将“帮助开发人员更好地决定将哪种模型用于什么目的,以及如何负责任地部署它们。”

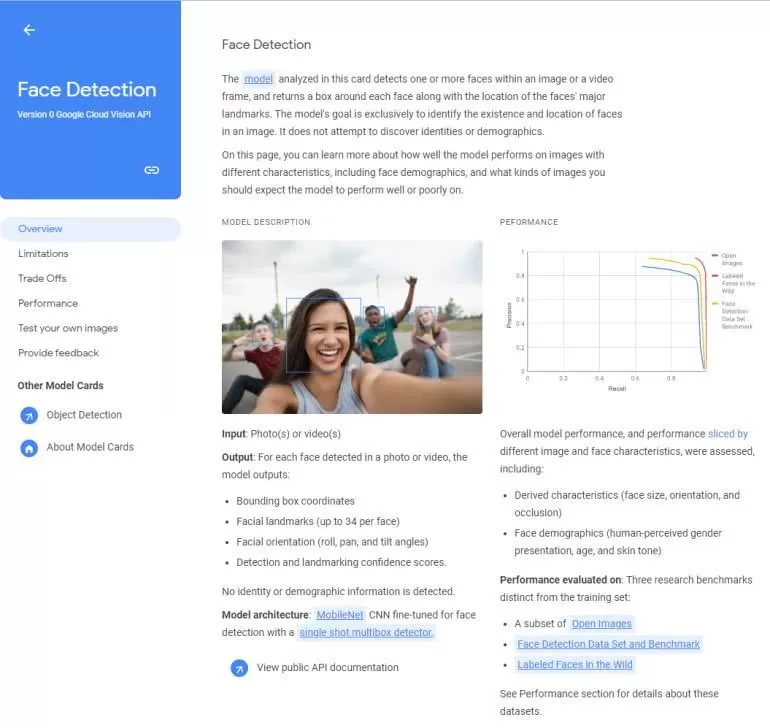

目前,Google已发布了两个模型卡示例,其中提供了有关人脸检测算法和对象检测算法的详细信息。

图片:Google模型卡

面部检测模型卡说明,该算法可能会受到面部尺寸,方向或光线不足的限制。

用户可以阅读有关模型输出的信息,如性能和局限性。例如,人脸检测模型卡说明该算法可能受到人脸尺寸,方向或光线不足的限制。

这次,宣布的新工具和功能是Google证明其遵守AI原则的尝试的一部分,该原则要求在开发该技术时提高透明度。而今年早些时候,谷歌解散了成立一周的AI道德委员会,该委员会旨在监督其谷歌对人工智能的使用。

相关文章

- 极智嘉发布全新RMS调度系统:智能算法自学习,安全易用双突破

- 马斯克表示X平台即将开源新的算法

- 终端数据+算法 玄瞳AI赋能地方区域产业升级的路径与价值

- 解码全球情感算法:钛动科技驱动短剧出海可复制增长

- 卓翼飞思实验室赋能首届具身智能系统及应用大会暨无人系统具身智能算法挑战赛

- 智AI“荐”未来:2025腾讯广告算法大赛圆满收官

- SOTA达成!腾讯优图D-Search算法登顶国际AI权威榜单

- 行业观察:软件定义汽车(SDV)时代来临,瑞典NIRA Dynamics以软件算法重塑汽车核心!

- 毛亮:在AI浪潮中重构人生算法

- 国家级硬核赛事丨2025首届无人系统具身智能算法挑战赛报名开启!

- Raythink燧石热像仪测温算法Ray Thermal S攻克高精度红外测温难关!

- 诸葛智能「分析师Agent」,入选BPAA全球算法大赛Top50

- 酷狗音乐上线「歌曲过渡」功能,AI算法打造流畅听感体验

- 智汇普陀,第五届BPAA算法大赛总决赛在沪收官

- 2025长三角(芜湖)算力算法创新应用大赛正式启动,聚焦“算力+产业”融合新实践

- 融合深度学习与量子计算,微美全息探索Grover算法量子神经网络模型