谷歌使用AI追踪2D视频中的物体 或可用于自动驾驶汽车物体识别

2020-04-02 11:50:06AI云资讯946

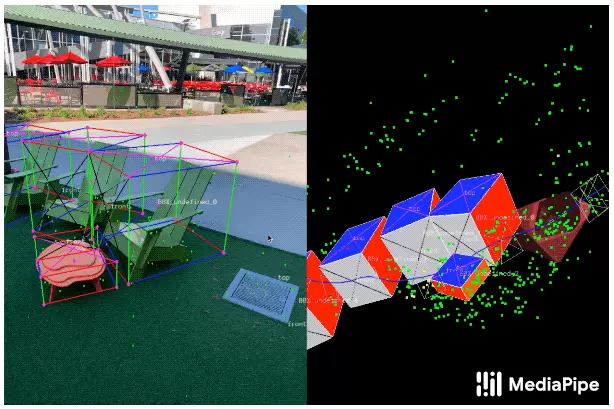

(图片来源:ai.googleblog.com)

追踪3D物体是一项复杂的工作,特别是当计算资源有限时。当仅有的可用图像为2D时,由于缺乏数据以及物体外观和形状多种多样,这会变得更加困难。

为此,Objectron研发团队开发了一种工具,可以使注释器通过分屏视角显示2D视频帧,来标记物体的3D边界框(即矩形边框)。这些3D边界框将叠加在点云数据、摄像头位置和识别到的平面上。注释器在3D视图中绘制3D边界框后,再通过查看2D视频帧中的投影来验证其位置。而对于静态物体,注释器只需在单个帧中标记目标物体象即可。该工具还使用AR会话数据中的实际摄像头姿态信息,将物体的位置传输到所有帧。

(图片来源:ai.googleblog.com)

为了补充真实世界的数据,以提高AI模型预测的准确性,该团队开发了一个引擎,将虚拟物体放入包含AR会话数据的场景中。这允许使用相机姿态信息、检测到的平面,以及估算的照明,生成物理上可能的、并具有与场景匹配的照明的位置,从而产生高质量的合成数据,其中的渲染物体符合场景的几何形状,并无缝融入真实背景。在验证试验中,合成数据的运用使AI模型预测准确性提高了约10%。

此外,该团队表示,当前版本的Objectron模型足够轻巧,可以在旗舰移动设备上实时运行。借助LG V60 ThinQ,三星Galaxy S20 +和Sony Xperia 1 II等手机中的Adreno 650移动图形芯片,该模型能够每秒处理约26帧。

Objectron在MediaPipe中可用,MediaPipe是一个框架,用于构建跨平台的AI管道,该管道包括快速推理和媒体处理(如视频解码)。提供训练有素的识别鞋子和椅子的模型,以及端到端演示应用程序。

该团队表示,未来计划与研发社区共享其他解决方案,以刺激新的用例、应用和研究工作。此外,该团队打算将Objectron模型进行扩展,以识别更多类别的物体,并进一步提高其在设备中的性能。

相关文章

- 谷歌云客户业务负责人重返微软,出任安全主管

- 谷歌年度营收首次突破4000亿美元

- 谷歌权威发布!2026 AI Agent智能体趋势,九科信息一文带你深入解读!

- 谷歌在Chrome浏览器中新增Gemini AI驱动的自动浏览功能

- 小水智能出席谷歌创业先锋闭门会 携手Gemini构建全球化儿童AI生态

- 苹果Siri搭载Gemini技术,或为谷歌创造高达50亿美元的价值

- 苹果用谷歌Gemini AI模型推动Siri重大升级

- 谷歌母公司Alphabet旗下Wing无人机提供送货服务的沃尔玛门店将新增150家

- OpenAI狂揽软银2800亿融资,谷歌/微美全息领衔AI军备竞赛重塑大模型格局

- 高通与谷歌深化合作 拓展骁龙数字底盘与Android系统融合生态

- 火山引擎中国第一、全球第三,Tokens调用量逼近谷歌!

- 谷歌发布Gemini 3 Flash加速AI搜索并增强图像生成能力

- 易海创腾受邀出席谷歌2026代理商大会,共话出海新生态

- 谷歌“打样”智能眼镜新范式,中国厂商凭供应链强势突围

- 谷歌将在AI模式下增加信息来源索引范围

- OpenAI宣布进入“红色警报”状态,谷歌在人工智能领域加速追赶