英特尔在量子计算领域提供AI突破

2019-03-15 09:06:03AI云资讯1413

但是,一些深刻的思想家已经在理论问题上停滞了好几年了。

周三,该小组展示了深度学习模拟量子计算中涉及的计算的卓越能力的证明。根据这些思想家的说法,在两种最成功的神经网络类型,卷积神经网络或CNN,以及递归神经网络或RNN中发生的信息冗余会产生重大影响。

去年由芯片巨头英特尔以141亿美元收购的自动驾驶技术公司Mobileye的总裁兼首席执行官Amnon Shashua周三在美国国家科学院主办的华盛顿特区会议上发布了调查结果。深度学习科学。

除了担任英特尔高级副总裁外,Shashua还是耶路撒冷希伯来大学的计算机科学教授,该论文与来自那里的同事Yoav Levine,主要作者Or Sharir以及Nadav共同撰写。普林斯顿大学高等研究院的科恩。

该报告“深度学习架构中的量子纠缠”本周发表在着名期刊“物理评论快报”上。这项工作既可以证明深度学习可以擅长的某些问题,也可以成为量子计算领域前景广阔的前提。

Amnon Shashua及其同事的团队创建了一个“CAC”或“卷积算术电路”,它复制了传统CNN中信息的重复使用,同时使其与物理学中常用的“Tensor Network”模型一起工作。

在量子计算中,这个问题在某种程度上与深度学习相反:许多引人注目的理论,但很少有真实的实例。多年来,Shashua和他的同事以及其他人一直在思考如何模拟所谓的多体问题的量子计算。

物理学家理查德马特克将多体问题定义为“研究身体之间相互作用对多体系统行为的影响”,其中身体与电子,原子,分子或其他各种实体有关。

Shashua和团队发现了什么,以及他们所说的已经证明的是,CNN和RNN比传统的机器学习方法更好,例如“受限玻尔兹曼机器”,一种在20世纪80年代开发的神经网络方法,一直是物理研究,特别是量子理论模拟。

“深度学习架构,”他们写道,“以深度卷积和循环网络的形式,可以有效地代表高度纠缠的量子系统。”

纠缠是量子系统中发生的物体相互作用之间的相互关系。实际的量子计算具有能够以极高的效率计算纠缠的巨大优势。模拟通过传统的电子计算可能非常困难,甚至难以处理。

“我们的工作量化了高度纠缠波函数表示的深度学习的力量,”他们写道,“理论上推动了在多体物理研究中转向采用最先进的深度学习架构。”

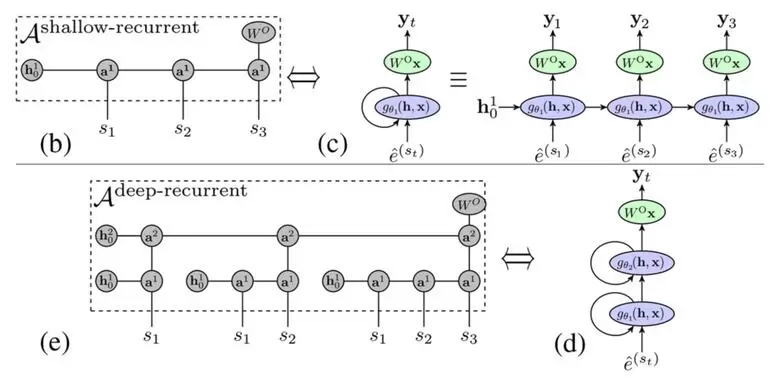

作者采用了递归神经网络或“RNN”的版本,并通过将数据重用添加到“递归运算电路”或RAC来对其进行修改。

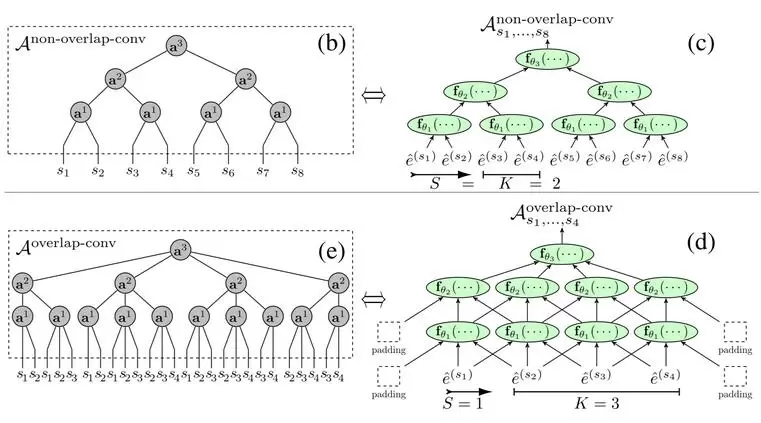

作者通过采用CNN和RNN并向他们提出他们设计的“扩展”来追究此事。他们将此称为“简单'技巧'”,并涉及前面提到的冗余。据Shashua及其同事说,事实证明。他们写道,事实证明,CNN和RNN的结构涉及信息的基本“重用”。

在CNN的情况下,“内核”,在图像上运行的滑动窗口在每个时刻重叠,使得图像的一部分被多次摄取到CNN。在RNN的情况下,在网络的每一层的信息的重复使用是类似的重用,在这种情况下是顺序数据点。

此外:谷歌表示人工智能的“指数”增长正在改变计算的本质

在这两种情况下,“尽管承认参数数量和计算成本仅仅呈线性增长,但这种建筑特征显示出网络表达能力的指数增长。”换句话说,通过堆叠多层实现的CNN和RNNS通过冗余的优点,在计算术语中具有更有效的“表示”。

例如,传统的“完全连接”神经网络 - 作者称之为“退伍军人”神经网络,需要计算时间,该时间可以表示为所表示的物体数量的平方。他们写道,RBM更好,计算时间可根据物体数量线性扩展。但是CNN和RNN可以更好,其所需的计算时间缩放为主体数量的平方根。

他们写道,相对于基于竞争的退伍军人基于神经网络的方法,这些属性“表明在深度卷积网络的体积法纠缠缩放建模方面具有显着优势”。 “实际上,重叠 - 卷积网络[...]可以支持任何2D系统的纠缠,最大尺寸为100×100,这是竞争难以实现的方法所无法实现的。”

为了做到这一点,作者不得不使用他们的“技巧”:表示量子计算的传统方式,即“张量网络”,不支持信息的重用。因此,作者创建了CNN和RNN的修改版本。第一种称为“卷积运算电路”或CAC。这是他们近年来在工作中不断发展的一种方法,在这里取得了更大的成果。技巧是在CAC中“重复输入数据本身”,这有效地复制了在CNN重叠中看到的重用。在RNN的情况下,他们创建了“循环运算电路”,其中它们复制输入信息。

“重要的是,由于深度RAC的每一层的输出向量在每个时间步被使用两次(作为下一层的输入,但也作为下一个时间步的隐藏向量),有一个固有的重用在网络计算期间的数据,“他们写道。 “因此,我们在重叠 - 卷积网络情况下复制输入,并获得深RAC的TN。”

所有这些的结果都是双重的:深度学习的证明,以及量子模拟的前进方向。包含在补充材料中的CAC和RAC效率的正式证明相当于证明深度学习方法可以更有效地解决量子纠缠。

他们最终有希望得出结论,他们的研究结果“可以帮助将量子多体物理学和最先进的机器学习方法更加接近。”

量子计算和深度学习可能再也不会相同。您认为深度学习在理论方面会取得多大进展?回话让我知道。

相关文章

- 英特尔正式为锐炫Alchemist和Battlemage显卡推出XeSS 3多帧生成技术

- 英特尔Panther Lake处理器推出紧凑型模块,亮相边缘AI与嵌入式平台

- 英特尔和AMD CPU缺货持续加剧,价格普遍上涨

- 香港科技大学与英特尔共建联合实验室,聚焦高能效智能计算

- DeepSeek最火Engram怎么跑?英特尔至强+AMX实测:性能提升达1.67倍!

- 英特尔与忆联共同推出企业级网络存储解决方案,全面赋能AI训练与推理效率跃升

- 鉴于散热性能问题,苹果iPhone芯片采用英特尔先进制程可能性几乎为零

- AMD服务器CPU市场份额最近7年增长了28%,英特尔的市场份额跌至72%

- 三星凭借与英伟达和苹果等巨头的长期合作,已在代工领域对英特尔形成压倒性优势

- AMD与英特尔或将服务器CPU价格上调15%,因超大规模数据中心建设已耗尽库存

- 全球同步首发!智微智能Mini AI工作站携英特尔Panther Lake强势登场

- 三星与英特尔联合推出OLED新技术,提升视觉效果的同时优化笔记本电脑续航

- 英特尔计划为游戏掌机开发定制版Panther Lake处理器

- 英特尔14A制程受到青睐,英伟达与AMD或将考虑其服务器CPU采用该制程

- 英特尔推进产学合作,探索构建机器人安全体系

- 多点 DMALL 携手英特尔 展现零售智能运营新实力