OpenAI首次采用Cerebras的AI芯片运行Codex模型,成功实现了每秒1000次事务处理量

2026-02-14 09:17:53AI云资讯1455

(AI云资讯消息)Cerebras的AI芯片首次获得主流采用,而采用者正是OpenAI。OpenAI透露,他们最新的Codex模型除了使用英伟达的算力外,还增加了另一家算力供应商。

在最新的Codex版本发布中,OpenAI透露,GPT-5.3-Codex-Spark模型正是由Cerebras的AI芯片提供动力,使用该硬件相比其他方案的优势在于推理任务中的低延迟。在此次算力选择中,OpenAI间接宣告了在推理领域出现了一个可以抗衡英伟达的对手。

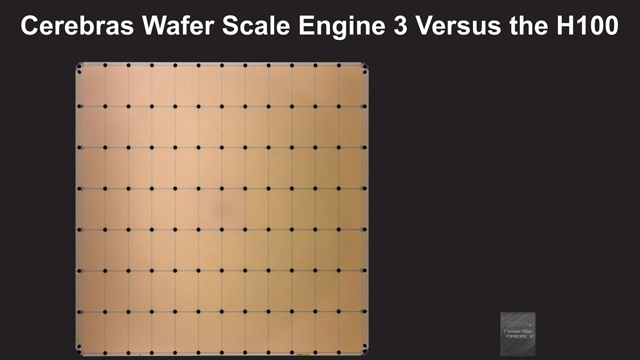

主流Codex模型与这里的Spark变体之间的区别在于,OpenAI称设计目的在于即刻完成工作。通过优化流程管道,借助Cerebras的硬件,GPT-5.3-Codex-Spark在模型延迟方面取得了重大改进。OpenAI声称,此版本将首字生成时间即从输入到输出第一个字的时间缩短了50%,这无疑是一个惊人的数据。Codex-Spark运行在Cerebras的晶圆级引擎3(Wafer Scale Engine 3)上。晶圆级引擎3采用台积电5nm制程节点,AI优化的可编程处理核心架构,约有4万亿晶体管数量,90万个AI优化核心,内存带宽达21PB/s,属于完整的300mm晶圆级芯片。

至于OpenAI为何选择Cerebras作为此次的算力供应商,原因有多方面。但其中最重要的一点是,借助晶圆级引擎3,OpenAI获得了惊人的内存带宽,这对于编码这类内存密集型任务至关重要。这也是为什么Codex-Spark能够实现每秒1000次事务处理,据称其响应速度可以媲美人类结对编程伙伴的原因。考虑到Blackwell架构更侧重于批量处理而非低延迟,若在英伟达的基础设施上训练Spark模型,在经济上并不划算,而这正是Cerebras在此场景下更具优势的原因。

当然在大规模推理方面,英伟达在Token经济中还是占据主导地位。英伟达Blackwell架构已将Token成本降低多达10倍。OpenAI的萨钦·卡蒂(SachinKatti)表示,与Cerebras的合作是为了增加互补能力,但在OpenAI的算力竞赛中,其核心忠诚度仍然完全倾向于英伟达。不过,通过Codex-Spark可以清晰地看到,当前的瓶颈在于延迟。而在硬件层面,英伟达的技术栈并未准备好主导这一领域。

鉴于Cerebras只是该领域内一个强大的竞争对手,此外还有来自ASIC制造商以及像AMD这样的竞争者所提供的新兴解决方案,看看推理市场未来将如何定位英伟达,只能拭目以待了。相关文章

- OpenAI首次采用Cerebras的AI芯片运行Codex模型,成功实现了每秒1000次事务处理量

- OpenAI开始向ChatGPT的低成本用户推送广告

- OpenAI推出企业级AI智能体平台Frontier

- 苹果为旗下编程工具接入Anthropic和OpenAI智能体功能

- 英伟达与OpenAI的千亿美元超级合作陷入停滞

- OpenAI试水ChatGPT广告业务,每千次曝光量收费60美元

- OpenAI宣布首款消费级AI设备预计2026年下半年上市

- OpenAI数据中心将自行承担能源成本并限制用水量

- OpenAI首席财务官表示2026年的工作重心是实际应用

- OpenAI将推出搭载三星2纳米Exynos芯片的无线耳机,自研Titan专用芯片预计年底问世

- OpenAI安全研究主管离职 跳槽至竞争对手Anthropic

- OpenAI狂揽软银2800亿融资,谷歌/微美全息领衔AI军备竞赛重塑大模型格局

- OpenAI推出ChatGPT Health,鼓励用户关联个人医疗记录

- OpenAI在进行测试ChatGPT广告,暂时不会在聊天中出现

- OpenAI推出全新旗舰级图像生成模型GPT Image 1.5

- 英伟达在AI图形处理器上部署训练OpenAI的GPT-5.2,为人工智能产业提速